Narzędzia do liczenia i rozwiązywania problemów przed pojawieniem się komputerów

Jednym z pierwszych urządzeń (V - IV wiek p.n.e.) ułatwiającym obliczenia było liczydło. Jest to specjalna tablica z wcięciami, na której wykonano obliczenia przesuwając kamyki lub kości.

Z biegiem czasu tablice te zaczęto dzielić na kilka pasków i kolumn. W Grecji liczydło istniało już w V wieku p.n.e., wśród Japończyków nazywało się je „serobyan”, wśród Chińczyków – „suanpan”. Na starożytnej Rusi do liczenia używano przyrządu przypominającego liczydło, nazywano go „rosyjskim hrabią”. W XVII wieku urządzenie to przybrało wygląd znanego rosyjskiego liczydła.

Historia rozwoju technologii komputerowej. Notatki z informatyki.

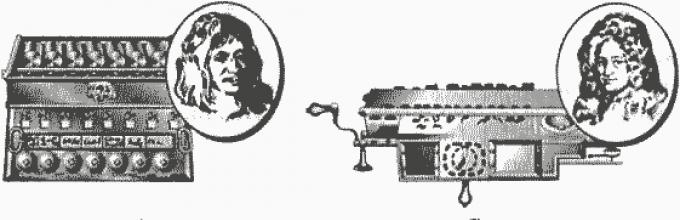

Na początku XVII w. francuski matematyk i fizyk Blaise Pascal stworzył pierwszą „maszynę dodającą, zwaną Pascaliną, która wykonywała dodawanie i odejmowanie. W latach 1670-1680 niemiecki matematyk Leibniz zaprojektował maszynę dodającą, która wykonywała wszystkie 4 działania arytmetyczne.

W 1874 r. petersburski inżynier Odner zaprojektował urządzenie zwane arytmometrem, które dość szybko wykonywało wszystkie cztery operacje arytmetyczne na liczbach wielocyfrowych. W latach 30-tych XX wieku opracowano w naszym kraju bardziej zaawansowaną maszynę sumującą „Felix”. Te urządzenia liczące były głównym środkiem technicznym ułatwiającym pracę osobom zajmującym się przetwarzaniem dużych ilości informacji liczbowych.

Ważnym wydarzeniem XIX wieku był wynalazek angielskiego matematyka Charlesa Babbage’a, który przeszedł do historii jako twórca pierwszego komputera – prototypu prawdziwych komputerów. W 1812 roku rozpoczął pracę nad swoim „silnikiem różnicowym”. Babbage chciał zaprojektować maszynę, która nie tylko wykonywałaby obliczenia, ale mogłaby także pracować według wcześniej skompilowanego programu, np. obliczać wartość liczbową danej funkcji. Głównym elementem jego maszyny było koło zębate – służące do przechowywania jednej cyfry liczby dziesiętnej. Dzięki temu możliwe było operowanie liczbami 18-bitowymi. Do 1822 roku naukowiec zbudował mały działający model i obliczył na nim tabelę kwadratów. Udoskonalając silnik różnicowy, Babbage zaczął w 1833 roku opracowywać „silnik analityczny”. Miał mieć większą prędkość, prostszą konstrukcję i być napędzany siłą pary. Silnik analityczny składał się z trzech głównych bloków. Pierwszy blok służy do przechowywania liczb (pamięć, zwana „magazynem”), drugi blok wykonuje operacje arytmetyczne („młyn”), trzeci blok służy do kontrolowania sekwencji działań maszyny. Nie zabrakło także urządzeń do wprowadzania danych początkowych i drukowania wyników. Maszyna musiała działać według programu, który określał kolejność operacji i przekazywanie liczb z pamięci do młyna i z powrotem. Matematyczka Ada Liveles (córka poety Byrona) opracowała pierwsze programy dla maszyny Babbage'a. Ze względu na niewystarczający rozwój technologii projekt Babbage'a nie został wdrożony, ale wielu wynalazców skorzystało z jego pomysłów. I tak w 1888 roku Amerykanin Hollerith stworzył tabulator, który umożliwił automatyzację obliczeń podczas spisu ludności. W 1924 roku Hollerith założył IBM, aby masowo produkować tabulatory.

Streszczenie - Historia rozwoju techniki komputerowej.

W 1941 roku niemiecki inżynier Zuse zbudował mały komputer oparty na przekaźnikach elektromechanicznych, jednak z powodu wojny jego prace nie doczekały się publikacji. W 1943 roku w USA, w jednym z przedsiębiorstw IBM, Aiken stworzył potężniejszy komputer „Mark-1”, który służył do obliczeń wojskowych. Ale przekaźniki elektromechaniczne były powolne i zawodne.

Pierwsza generacja komputerów (1946 - połowa lat 50.) Generacja komputerów odnosi się do wszystkich typów i modeli komputerów opracowanych przez różne zespoły projektowe, ale zbudowanych w oparciu o te same zasady naukowo-techniczne.

Pojawienie się elektronowej lampy próżniowej doprowadziło do powstania pierwszego komputera. W 1946 roku w USA pojawił się komputer do rozwiązywania problemów o nazwie ENIAC (Electronic Numerical Integrator and Calculator). Komputer ten działał tysiąc razy szybciej niż Mark 1. Ale przez większość czasu był bezczynny, ponieważ... Aby ukończyć program, prawidłowe podłączenie przewodów zajęło kilka godzin.

Zbiór elementów tworzących komputer nazywany jest bazą elementów. Podstawą elementarną komputerów pierwszej generacji są elektronowe lampy próżniowe, rezystory i kondensatory. Elementy połączono przewodami za pomocą montażu nad głową. Komputer składał się z wielu nieporęcznych szafek i zajmował specjalne pomieszczenie komputerowe, ważył setki ton i zużywał setki kilowatów energii elektrycznej. ENIAC miał 20 tysięcy lamp próżniowych. Za 1 sek. Maszyna wykonała 300 operacji mnożenia lub 5000 operacji dodawania liczb wielocyfrowych.

W 1945 roku słynny amerykański matematyk John von Neumann przedstawił społeczeństwu naukowemu raport, w którym udało mu się nakreślić formalną logiczną organizację komputera, abstrahując od obwodów i lamp radiowych.

Historia rozwoju technologii komputerowej. Klasyczne zasady organizacji funkcjonalnej i działania komputera:

1. Dostępność głównych urządzeń: jednostka sterująca (CU), jednostka arytmetyczno-logiczna (ALU), urządzenie pamięci masowej (RAM), urządzenia wejścia-wyjścia;

2. Przechowywanie danych i poleceń w pamięci;

3. Zasada kontroli programowej;

4. Sekwencyjne wykonywanie operacji;

5. Binarne kodowanie informacji (pierwszy komputer „Mark-1” wykonywał obliczenia w systemie dziesiętnym, ale takie kodowanie jest trudne technicznie do wdrożenia i później zostało zarzucone);

6. Zastosowanie elementów elektronicznych i obwodów elektrycznych dla większej niezawodności (zamiast przekaźników elektromechanicznych).

Pierwszy komputer domowy powstał w 1951 roku pod przewodnictwem akademika S.A. Lebe-maiden i nazywała się MESM (mała elektroniczna maszyna licząca). Później powstała BESM-2 (duża elektroniczna maszyna licząca). Najpotężniejszym komputerem pierwszej generacji w Europie był radziecki komputer M-20 o prędkości 20 tys. operacji na sekundę i pojemności RAM 4000 słów maszynowych. Średnia prędkość komputera pierwszej generacji wynosi 10-20 tysięcy ops/s. Działanie komputerów pierwszej generacji jest zbyt skomplikowane ze względu na częste awarie: często przepalały się lampy elektroniczne i trzeba było je wymieniać ręcznie. W serwisowanie takiego komputera zaangażowana była cała kadra inżynierów. Programy dla takich maszyn pisano w kodzie maszynowym, trzeba było znać wszystkie polecenia maszyny i ich binarną reprezentację. Ponadto takie komputery kosztują miliony dolarów.

Historia rozwoju technologii komputerowej. Druga generacja komputerów (koniec lat 50. - 60.)

Wynalezienie tranzystora w 1948 r. umożliwiło zmianę podstawy elementu komputera na elementy półprzewodnikowe (tranzystory i diody), a także bardziej zaawansowane rezystory i kondensatory. Jeden tranzystor zastąpił 40 lamp próżniowych, działał szybciej, był tańszy i bardziej niezawodny. Zmieniła się technologia łączenia podstawy elementu: pojawiły się pierwsze płytki drukowane - płytki z materiału izolacyjnego, na których umieszczono tranzystory, diody, rezystory i kondensatory. Płytki drukowane połączono metodą montażu powierzchniowego. Zmniejszono zużycie energii elektrycznej, a wymiary zmniejszyły się setki razy. Wydajność takich komputerów sięga 1 miliona operacji/sek. W przypadku awarii kilku elementów wymieniana była cała płytka, a nie każdy element z osobna. Po pojawieniu się tranzystorów najbardziej pracochłonną operacją w produkcji komputerów było łączenie i lutowanie tranzystorów w celu utworzenia obwodów elektronicznych. Pojawienie się języków algorytmicznych ułatwiło proces pisania programów. Wprowadzono zasadę podziału czasu – różne urządzenia komputerowe zaczęły pracować jednocześnie. W 1965 roku firma Digital Equipment wypuściła na rynek pierwszy minikomputer, PDP-8, wielkości lodówki i kosztujący zaledwie 20 000 dolarów.

Historia rozwoju technologii komputerowej. Trzecia generacja komputerów(koniec lat 60. - 70.)

W 1958 roku John Kilby po raz pierwszy stworzył prototyp układu scalonego lub chipa. Układ scalony spełniał te same funkcje, co układ elektroniczny w komputerze drugiej generacji. Była to płytka krzemowa, na której umieszczono tranzystory i wszystkie połączenia między nimi. Baza elementów - układy scalone. Wydajność: setki tysięcy - miliony operacji na sekundę. Pierwszym komputerem wykonanym na układach scalonych był IBM-360 z 1968 roku firmy IBM, co zapoczątkowało całą serię (im wyższa liczba, tym większe możliwości komputera). W 1970 roku Intel rozpoczął sprzedaż układów scalonych pamięci. Następnie liczba tranzystorów na jednostkę powierzchni układu scalonego zwiększała się w przybliżeniu dwukrotnie rocznie. Zapewniło to stałą redukcję kosztów i zwiększenie szybkości komputera. Zwiększyła się pojemność pamięci. Pojawiły się wyświetlacze i plotery, a także nadal rozwijały się różne języki programowania. W naszym kraju wyprodukowano dwie rodziny komputerów: dużą (na przykład ES-1022, ES-1035) i małą (na przykład SM-2, SM-3). W tym czasie centrum komputerowe było wyposażone w jeden lub dwa modele komputerów EC oraz klasę wyświetlaczy, na której każdy programista mógł połączyć się z komputerem w trybie podziału czasu.

Historia rozwoju technologii komputerowej. Czwarta generacja komputerów (koniec lat 70. do chwili obecnej)

W 1970 roku Marchian Edward Hoff z Intela zaprojektował układ scalony o działaniu podobnym do jednostki centralnej dużego komputera. Tak pojawił się pierwszy mikroprocesor Intel-4004, który został wprowadzony do sprzedaży w 1971 roku. Ten mikroprocesor o wielkości niecałych 3 cm był bardziej produktywny niż gigantyczna maszyna. Na jednym krysztale krzemu można było umieścić 2250 tranzystorów. Co prawda działał znacznie wolniej i mógł przetwarzać tylko 4 bity informacji na raz (zamiast 16-32 bitów w przypadku dużych komputerów), ale kosztował też dziesiątki tysięcy razy mniej (około 500 dolarów). Wydajność mikroprocesora wkrótce zaczęła gwałtownie rosnąć. Mikroprocesory po raz pierwszy zastosowano w różnych urządzeniach komputerowych (takich jak kalkulatory). W 1974 roku kilka firm ogłosiło powstanie komputera osobistego opartego na mikroprocesorze Intel-8008, tj. urządzenie przeznaczone dla jednego użytkownika.

Powszechna sprzedaż komputerów osobistych (PC) na rynku związana jest z nazwiskami młodych Amerykanów S. Jobsa i V. Woźniaka, założycieli firmy Apple Computer, która rozpoczęła produkcję komputerów osobistych Apple w 1977 roku. Do wzrostu sprzedaży przyczyniła się duża liczba programów przeznaczonych do zastosowań biznesowych (edycja tekstu, arkusze kalkulacyjne dla księgowości).

Pod koniec lat siedemdziesiątych wzrost liczby komputerów osobistych doprowadził do spadku popytu na duże komputery. Zaniepokoiło to kierownictwo IBM, wiodącej firmy w produkcji dużych komputerów, i postanowiło w ramach eksperymentu spróbować swoich sił na rynku komputerów osobistych. Aby nie wydawać dużych pieniędzy na ten eksperyment, działowi odpowiedzialnemu za ten projekt pozwolono nie projektować komputera PC od podstaw, ale korzystać z bloków wyprodukowanych przez inne firmy. Dlatego jako główny mikroprocesor wybrano najnowszy 16-bitowy mikroprocesor Intel-8088. Oprogramowanie zostało zlecone przez małą firmę Microsoft. W sierpniu 1981 roku nowy IBM PC był gotowy i stał się bardzo popularny wśród użytkowników. IBM nie uczynił ze swojego komputera pojedynczego urządzenia typu „wszystko w jednym” i nie zabezpieczył swojej konstrukcji patentami. Zamiast tego złożyła komputer z niezależnie wyprodukowanych części i nie zachowała w tajemnicy sposobu, w jaki te części zostały złożone; Projekty IBM PC były dostępne dla każdego. Umożliwiło to innym firmom rozwój zarówno sprzętu, jak i oprogramowania. Bardzo szybko firmy te przestały zadowalać się rolą producentów komponentów do IBM PC i zaczęły samodzielnie montować komputery PC kompatybilne z IBM PC. Konkurencja między producentami doprowadziła do tańszych komputerów. Ponieważ firmy te nie musiały ponosić ogromnych kosztów badań, mogły sprzedawać swoje komputery znacznie taniej niż podobne komputery IBM. Komputery kompatybilne z IBM PC nazywano „klonami” (dubletami). Wspólną cechą rodziny IBM PC i komputerów z nią kompatybilnych jest kompatybilność oprogramowania i zasada otwartej architektury, tj. możliwość dodawania i wymiany istniejącego sprzętu na nowszy, bez konieczności wymiany całego komputera.

Jedną z najważniejszych idei komputerów czwartej generacji jest to, że do przetwarzania informacji wykorzystuje się jednocześnie kilka procesorów (przetwarzanie wieloprocesorowe).

Historia rozwoju technologii komputerowej. Serwer.

Serwer to potężny komputer w sieciach komputerowych, który zapewnia obsługę podłączonych do niego komputerów i dostęp do innych sieci. Superkomputery pojawiły się już w latach 70. W odróżnieniu od komputerów o strukturze Neumanna wykorzystują one wieloprocesorową metodę przetwarzania. Dzięki tej metodzie rozwiązywany problem jest podzielony na kilka części, z których każda jest rozwiązywana równolegle na własnym procesorze. To radykalnie zwiększa produktywność. Ich prędkość wynosi miliardy operacji na sekundę. Ale takie komputery kosztują miliony dolarów.

Komputery osobiste (PC) są używane wszędzie i mają przystępną cenę. Opracowano dla nich wiele narzędzi programowych do różnych zastosowań, które pomagają osobie przetwarzać informacje. Teraz komputer PC stał się multimedialny, tj. przetwarza nie tylko informacje numeryczne i tekstowe, ale efektywnie współpracuje z dźwiękiem i obrazem.

Komputery przenośne (łacińskie słowo „porto” oznacza „nosić”) to komputery przenośne. Najpopularniejszym z nich jest notatnik („notatnik”) – komputer osobisty typu notebook.

Komputery przemysłowe są przeznaczone do użytku w warunkach przemysłowych (na przykład do sterowania obrabiarkami, samolotami i pociągami). Podlegają podwyższonym wymaganiom w zakresie niezawodności bezawaryjnej pracy, odporności na zmiany temperatury, wibracje itp. Dlatego też zwykłe komputery osobiste nie mogą być używane jako komputery przemysłowe.

Historia rozwoju technologii komputerowej. w. 1,0.

Po przestudiowaniu tego tematu dowiesz się:

Jak narzędzia obliczeniowe i rozwiązywania problemów rozwijały się przed stworzeniem komputerów;

- jaka jest baza elementarna i jak jej zmiany wpłynęły na powstawanie nowych typów komputerów;

- Jak technologia komputerowa rozwijała się z pokolenia na pokolenie.

Narzędzia do liczenia i rozwiązywania problemów przed pojawieniem się komputerów

Historia informatyki sięga wieków wstecz, podobnie jak historia rozwoju człowieka. Gromadzenie rezerw, podział łupów, wymiana - wszystkie te działania wiążą się z obliczeniami. Do obliczeń ludzie używali własnych palców, kamyków, patyków, węzłów itp.

Konieczność znajdowania rozwiązań coraz bardziej złożonych problemów, a co za tym idzie coraz bardziej skomplikowanych i czasochłonnych obliczeń, postawiła człowieka przed koniecznością poszukiwania sposobów i wymyślania urządzeń, które mogłyby mu w tym pomóc. Historycznie rzecz biorąc, różne kraje opracowały własne jednostki monetarne, miary masy, długości, objętości, odległości itp. Aby przejść z jednego systemu miar na inny, potrzebne były obliczenia, które zwykle mogły wykonywać jedynie specjalnie przeszkolone osoby, które dokładnie znały cała sekwencja działań. Często byli zapraszani nawet z innych krajów. I całkiem naturalnie pojawiła się potrzeba wynalezienia urządzeń pomagających w liczeniu. W ten sposób stopniowo zaczęli pojawiać się asystenci mechaniczni. Do dziś przetrwały dowody wielu takich wynalazków, które na zawsze weszły do historii techniki.

Jedno z pierwszych urządzeń (V-IV wieki p.n.e.), które ułatwiało obliczenia, można uznać za specjalne urządzenie, zwane później liczydłem (ryc. 24.1). Pierwotnie była to deska posypana cienką warstwą drobnego piasku lub mączki błękitnej gliny. Można było na nim pisać litery i cyfry za pomocą zaostrzonego patyka. Następnie udoskonalono liczydło i przeprowadzono już na nim obliczenia, przesuwając kości i kamyki w podłużnych wgłębieniach, a same deski zaczęto wykonywać z brązu, kamienia, kości słoniowej itp. Z czasem deski te zaczęto dzielić na kilka pasków i kolumn. W Grecji liczydło istniało już w V wieku p.n.e. e. Japończycy nazwali to urządzenie „Serobyan”, Chińczycy nazywali je „suan-pan”.

Ryż. 24.1. Liczydło

Na starożytnej Rusi do liczenia używano przyrządu przypominającego liczydło i nazywano go „rosyjskim szkotem”. W XVII wieku urządzenie to miało już wygląd znanego rosyjskiego liczydła, które można spotkać do dziś.

Na początku XVII wieku, kiedy matematyka zaczęła odgrywać kluczową rolę w nauce, coraz bardziej odczuwalna była potrzeba wynalezienia maszyny liczącej. W tym czasie młody francuski matematyk i fizyk Blaise Pascal stworzył pierwszą maszynę liczącą (ryc. 24.2, a), zwaną Pascaliną, która wykonywała dodawanie i odejmowanie.

Ryż. 24.2. Maszyny liczące XVII wieku: a) Pascalina, b) maszyna Leibniza

W latach 1670–1680 niemiecki matematyk Gottfried Leibniz zaprojektował maszynę liczącą (ryc. 24.2, b), która wykonywała wszystkie cztery operacje arytmetyczne.

W ciągu następnych dwustu lat wynaleziono i zbudowano jeszcze kilka podobnych urządzeń liczących, które ze względu na szereg niedociągnięć nie znalazły szerokiego zastosowania.

Dopiero w 1878 r. rosyjski naukowiec P. Czebyszew zaprojektował maszynę liczącą, która wykonywała dodawanie i odejmowanie liczb wielocyfrowych. Najpowszechniej stosowaną wówczas była maszyna sumująca, zaprojektowana przez petersburskiego inżyniera Odnera w 1874 roku. Konstrukcja urządzenia okazała się bardzo udana, gdyż umożliwiła dość szybkie wykonanie wszystkich czterech operacji arytmetycznych.

W latach 30. XX wieku w naszym kraju opracowano bardziej zaawansowaną maszynę sumującą – „Felix” (ryc. 24.3). Te urządzenia liczące były używane przez kilkadziesiąt lat i były głównym środkiem technicznym ułatwiającym pracę osobom zajmującym się przetwarzaniem dużych ilości informacji liczbowych.

Ryż. 24.3. Maszyna sumująca Felix

Ważnym wydarzeniem XIX wieku był wynalazek angielskiego matematyka Charlesa Babbage'a, który przeszedł do historii jako wynalazca pierwszego komputera - prototypu współczesnych komputerów. W 1812 roku rozpoczął pracę nad tzw. maszyną różnicową. Poprzednie komputery Pascala i Leibniza wykonywały wyłącznie operacje arytmetyczne. Babbage dążył do skonstruowania maszyny, która wykonałaby określony program i obliczyła wartość liczbową danej funkcji. Jako główny element silnika różnicowego Babbage użył przekładni do przechowywania jednej cyfry liczby dziesiętnej. Dzięki temu był w stanie operować liczbami 18-bitowymi. Do 1822 roku zbudował mały działający model i obliczył na nim tabelę kwadratów.

Po udoskonaleniu silnika różnicowego Babbage zaczął w 1833 roku opracowywać silnik analityczny (rysunek 24.4). Od silnika różnicowego miał się różnić tym, że był szybszy i miał prostszą konstrukcję. Według projektu nowa maszyna miała być napędzana siłą pary.

Silnik analityczny został pomyślany jako urządzenie czysto mechaniczne składające się z trzech głównych bloków. Pierwszy blok to urządzenie do przechowywania liczb w rejestrach utworzonych z kół zębatych i system przekazujący te liczby z jednego węzła do drugiego (we współczesnej terminologii jest to pamięć). Drugi blok to urządzenie umożliwiające wykonywanie operacji arytmetycznych. Babbage nazwał go „młynem”. Trzeci blok miał za zadanie kontrolować kolejność działań maszyny. Konstrukcja silnika analitycznego uwzględniała także urządzenie do wprowadzania danych początkowych i drukowania uzyskanych wyników.

Założono, że maszyna będzie działać według programu, który będzie określał kolejność operacji oraz przekazywanie liczb z pamięci do młyna i z powrotem. Programy z kolei należało zakodować i przenieść na karty dziurkowane. Już wówczas stosowano podobne karty do automatycznego sterowania maszynami tkackimi. W tym samym czasie matematyczka Lady Ada Lovelace – córka angielskiego poety Lorda Byrona – opracowała pierwsze programy dla maszyny Babbage’a. Przedstawiła wiele pomysłów i wprowadziła szereg pojęć i terminów, które są nadal używane.

Ryż. 24.4. Silnik analityczny Babbage’a

Niestety z powodu niewystarczającego rozwoju technologii projekt Babbage'a nie został zrealizowany. Niemniej jednak jego praca była ważna; wielu kolejnych wynalazców wykorzystywało idee leżące u podstaw wymyślonych przez niego urządzeń.

Konieczność automatyzacji obliczeń spisowych w Stanach Zjednoczonych skłoniła Heinricha Holleritha do stworzenia w 1888 roku urządzenia zwanego tabulatorem (ryc. 24.5), w którym informacje wydrukowane na kartach dziurkowanych były odszyfrowywane za pomocą prądu elektrycznego. Urządzenie to umożliwiło przetworzenie danych spisowych w ciągu zaledwie 3 lat zamiast wymaganych wcześniej ośmiu lat. W 1924 roku Hollerith założył IBM, aby masowo produkować tabulatory.

Ryż. 24,5. Tabulator

Na rozwój technologii komputerowej duży wpływ miał rozwój teoretyczny matematyków: pracującego niezależnie od niego Anglika A. Turinga i Amerykanina E. Posta. „Maszyna Turinga (Post)” jest prototypem programowalnego komputera. Naukowcy ci wykazali zasadniczą możliwość rozwiązania przez automaty dowolnego problemu, pod warunkiem, że można go przedstawić w postaci algorytmu skupionego na operacjach wykonywanych przez maszynę.

Od momentu pojawienia się pomysłu Babbage’a na stworzenie silnika analitycznego do jego rzeczywistej realizacji w życiu minęło ponad półtora wieku. Dlaczego różnica czasowa pomiędzy narodzinami pomysłu a jego techniczną realizacją była tak duża? Wynika to z faktu, że podczas tworzenia dowolnego urządzenia, w tym komputera, bardzo ważnym czynnikiem jest wybór podstawy elementu, czyli tych części, z których składa się cały system.

Pierwsza generacja komputerów

Pojawienie się elektronowej lampy próżniowej pozwoliło naukowcom zrealizować pomysł stworzenia komputera. Pojawił się w 1946 roku w USA i otrzymał nazwę ENIAC.(ENIAC – Electronic Numerical Integrator and Calculator, „elektroniczny integrator numeryczny i kalkulator” – rysunek 24.6). Wydarzenie to zapoczątkowało ścieżkę rozwoju komputerów elektronicznych (komputerów).

Rysunek 24.6. Pierwszy komputer ENIAC

Dalsze doskonalenie komputerów było zdeterminowane rozwojem elektroniki, pojawieniem się nowych elementów i zasad działania, czyli udoskonalaniem i poszerzaniem bazy elementów. Obecnie istnieje kilka generacji komputerów. Generacja komputerów odnosi się do wszystkich typów i modeli komputerów elektronicznych, opracowanych przez różne zespoły projektowe, ale zbudowanych na tych samych zasadach naukowych i technicznych. Zmiana pokoleń została zdeterminowana pojawieniem się nowych elementów wykonanych przy użyciu zasadniczo różnych technologii.

Pierwsza generacja (1946 - połowa lat 50.). Podstawą elementarną były elektronowe lampy próżniowe zamontowane na specjalnych obudowach oraz rezystory i kondensatory. Elementy połączono przewodami stosując montaż podwieszany. Komputer ENIAC miał 20 tysięcy lamp próżniowych, z czego miesięcznie wymieniano 2000. W ciągu jednej sekundy maszyna wykonywała 300 operacji mnożenia, czyli 5000 dodawania liczb wielocyfrowych.

Wybitny matematyk John von Neumann i jego współpracownicy przedstawili w swoim raporcie podstawowe zasady budowy logicznej nowego typu komputera, które później wdrożono w projekcie EDVAC (1950). W raporcie wskazano, że komputer powinien być zbudowany w oparciu o technologię elektroniczną i działać w systemie liczb binarnych. Powinna obejmować urządzenia: arytmetyczne, centralnego sterowania, przechowywania, służące do wprowadzania danych i wyprowadzania wyników. Naukowcy sformułowali także dwie zasady działania: zasadę sterowania programem z sekwencyjnym wykonywaniem poleceń oraz zasadę zapisanego programu. Projekt większości komputerów kolejnych generacji, w których zastosowano te zasady, nazwano „architekturą von Neumanna”.

Pierwszy komputer domowy powstał w 1951 roku pod przewodnictwem akademika S. A. Lebiediewa i nazwano go MESM (mała elektroniczna maszyna licząca). Następnie uruchomiono BESM-2 (dużą elektroniczną maszynę liczącą). Najpotężniejszym komputerem lat 50. w Europie był radziecki komputer elektroniczny M-20 o prędkości 20 tys. operacji na sekundę i pojemności RAM wynoszącej 4000 słów maszynowych.

MESM (mała elektroniczna maszyna licząca)

Od tego czasu rozpoczął się szybki rozkwit krajowej techniki komputerowej i pod koniec lat 60-tych najwydajniejszy (1 milion op/s) komputer tamtych czasów, BESM-6, z powodzeniem działał w naszym kraju, w w którym wdrożono wiele zasad działania kolejnych generacji komputerów.

BESM-6 (duża elektroniczna maszyna sumująca)

Wraz z pojawieniem się nowych modeli komputerów nastąpiły zmiany w nazwie tej dziedziny działalności. Wcześniej każdą technikę stosowaną do obliczeń nazywano ogólnie „przyrządami i urządzeniami obliczeniowymi”. Wszystko, co ma związek z komputerami, nazywa się technologią komputerową.

Wymieńmy cechy charakterystyczne komputerów pierwszej generacji.

♦ Podstawa elementu: lampy elektronowe, rezystory, kondensatory. Połączenie elementów: instalacja podwieszana za pomocą przewodów.

♦ Wymiary: Komputer wykonany jest w formie ogromnych szafek i zajmuje specjalne pomieszczenie komputerowe.

♦ Wydajność: 10-20 tys. operacji/s.

♦ Obsługa jest zbyt trudna ze względu na częste awarie lamp próżniowych. Istnieje ryzyko przegrzania komputera.

♦ Programowanie: pracochłonny proces w kodach maszynowych. W tym przypadku konieczna jest znajomość wszystkich poleceń maszyny, ich reprezentacji binarnej i architektury komputera. Zajmowali się tym głównie matematycy-programiści, którzy bezpośrednio pracowali przy jego panelu sterowania. Konserwacja komputerów wymagała od personelu wysokiego profesjonalizmu.

Druga generacja komputerów

Drugie pokolenie występuje od końca lat 50. do końca lat 60.

W tym czasie wynaleziono tranzystor, który zastąpił lampy próżniowe. Umożliwiło to wymianę podstawy elementu komputera na elementy półprzewodnikowe (tranzystory, diody), a także rezystory i kondensatory o bardziej zaawansowanej konstrukcji (rysunek 24.7). Jeden tranzystor zastąpił 40 lamp próżniowych, pracował z większą prędkością, był tańszy i bardziej niezawodny. Jego średnia żywotność była 1000 razy dłuższa niż lamp próżniowych.

Zmieniła się także technologia łączenia elementów. Pojawiły się pierwsze płytki drukowane (patrz ryc. 24.7) - płytki wykonane z materiału izolacyjnego, na przykład getinaxu, na które za pomocą specjalnej technologii fotomontażu nałożono materiał przewodzący. Nie zabrakło specjalnych gniazd do mocowania podstawy elementu do płytki drukowanej.

Ryż. 24,7. Tranzystory, diody, rezystory, kondensatory i płytki drukowane

Taka formalna wymiana jednego typu elementu na inny znacząco wpłynęła na wszystkie cechy komputera: wymiary, niezawodność, wydajność, warunki pracy, styl programowania i działanie maszyny. Zmienił się proces technologiczny produkcji komputerów.

Ryż. 24,8. Komputer drugiej generacji

Wymieńmy cechy charakterystyczne komputerów drugiej generacji (rysunek 24.8).

- Podstawa elementu

: elementy półprzewodnikowe. Łączenie elementów: płytki drukowane i montaż naścienny.

- Wymiary

: Komputery są wykonane w formie identycznych stojaków, nieco wyższych niż wzrost człowieka. Aby je pomieścić, wymagana jest specjalnie wyposażona maszynownia, w której pod podłogą prowadzone są kable łączące liczne autonomiczne urządzenia.

- Wydajność

: od setek tysięcy do 1 miliona operacji/s.

- Eksploatacja

: uproszczone. Pojawiły się centra komputerowe z dużą kadrą personelu serwisowego, w których zwykle instalowano kilka komputerów. Tak narodziła się koncepcja scentralizowanego przetwarzania informacji na komputerach. W przypadku awarii kilku elementów wymieniano całą płytkę, a nie każdy element z osobna, jak w komputerach poprzedniej generacji.

- Programowanie

: uległ znaczącym zmianom, odkąd zaczęto go wykonywać głównie w językach algorytmicznych. Programiści nie pracowali już na hali, ale swoje programy na kartach dziurkowanych lub taśmach magnetycznych przekazywali specjalnie przeszkolonym operatorom. Problemy rozwiązywano w trybie wsadowym (wieloprogramowym), to znaczy wszystkie programy były wprowadzane do komputera jeden po drugim, a ich przetwarzanie odbywało się w miarę zwalniania odpowiednich urządzeń. Wyniki rozwiązania wydrukowano na specjalnym papierze perforowanym wzdłuż krawędzi.

- Zmiany nastąpiły zarówno w strukturze komputera, jak i zasadzie jego organizacji

. Sztywna zasada sterowania została zastąpiona mikroprogramowaniem. Aby zrealizować zasadę programowalności, konieczne jest posiadanie w komputerze trwałej pamięci, której komórki zawsze zawierają kody odpowiadające różnym kombinacjom sygnałów sterujących. Każda taka kombinacja pozwala na wykonanie podstawowej operacji, czyli podłączenie określonych obwodów elektrycznych.

- Wprowadzono zasadę podziału czasu

, co zapewniło kombinację czasową działania różnych urządzeń, np. urządzenie wejścia/wyjścia taśmy magnetycznej działa jednocześnie z procesorem.

Trzecia generacja komputerów

Okres ten trwa od końca lat 60. do końca lat 70. Tak jak wynalezienie tranzystorów doprowadziło do powstania komputerów drugiej generacji, tak pojawienie się układów scalonych wyznaczyło nowy etap w rozwoju technologii komputerowej - narodziny maszyn trzeciej generacji.

W 1958 roku John Kilby jako pierwszy stworzył prototypowy układ scalony. Takie obwody mogą zawierać dziesiątki, setki, a nawet tysiące tranzystorów i innych elementów, które są fizycznie nierozłączne. Układ scalony (rysunek 24.9) spełnia te same funkcje, co podobny układ oparty na bazie elementarnej komputera drugiej generacji, ale jednocześnie ma znacznie mniejsze rozmiary i wyższy stopień niezawodności.

Ryż. 24.9. Obwody scalone Pierwszym komputerem wykonanym na układach scalonych był IBM-360 firmy IBM. Oznaczało to początek dużej serii modeli, których nazwa zaczynała się od IBM, a liczba ta rosła w miarę ulepszania modeli tej serii. Oznacza to, że im większa liczba, tym większe możliwości oferowane użytkownikowi.

Podobne komputery zaczęto produkować w krajach CMEA (Rada Wzajemnej Pomocy Gospodarczej): ZSRR, Bułgaria, Węgry, Czechosłowacja, NRD, Polska. Były to wspólne opracowania, w których każdy kraj specjalizował się w określonych urządzeniach. Wyprodukowano dwie rodziny komputerów:

- duże - komputery ES (ujednolicony system), np. ES-1022, ES-1035, ES-1065;

- mały - komputer SM (mały system), np. SM-2, SM-3, SM-4.

Komputer ES (pojedynczy system) ES-1035

KOMPUTER SM (mały system) SM-3

W tamtym czasie każde centrum komputerowe było wyposażone w jeden lub dwa modele komputerów ES (rysunek 24.10). Przedstawicieli rodziny komputerów SM, tworzących klasę minikomputerów, można było spotkać dość często w laboratoriach, na produkcji, na liniach produkcyjnych i na stanowiskach testowych. Osobliwością tej klasy komputerów było to, że wszystkie mogły pracować w czasie rzeczywistym, to znaczy skupiać się na konkretnym zadaniu.

Ryż. 24.10. Komputer trzeciej generacji

Przedstawmy cechy charakterystyczne komputerów trzeciej generacji.

- Podstawa elementu

: Układy scalone wkładane do specjalnych gniazd na płytce drukowanej.

- Wymiary

: Zewnętrzna konstrukcja komputera ES jest podobna do komputera drugiej generacji. Aby je pomieścić, wymagana jest także maszynownia. A małe komputery to w zasadzie dwa stojaki o wysokości około półtora człowieka i wyświetlacz. Nie potrzebowali, jak komputery ES, specjalnie wyposażonego pomieszczenia.

- Produktywność

: od setek tysięcy do milionów operacji na sekundę.

- Eksploatacja

: nieco się zmieniło. Regularne usterki są naprawiane szybciej, jednak ze względu na dużą złożoność organizacji systemu wymagana jest kadra wysoko wykwalifikowanych specjalistów. Programista systemu odgrywa dużą rolę.

- Technologia programowania i rozwiązywania problemów

: tak samo jak na poprzednim etapie, choć nieco zmienił się charakter interakcji z komputerem. W wielu centrach komputerowych pojawiły się sale wystawowe, w których każdy programista o określonej godzinie mógł połączyć się z komputerem w trybie podziału czasu. Podobnie jak poprzednio, tryb wsadowego przetwarzania zadań pozostał głównym.

- Nastąpiły zmiany w strukturze komputera

. Oprócz metody sterowania mikroprogramowego stosowane są zasady modułowości i trunkingu. Zasada modułowości przejawia się w budowaniu komputera w oparciu o zestaw modułów – kompletnych konstrukcyjnie i funkcjonalnie jednostek elektronicznych o standardowej konstrukcji. Przez magistralę rozumiemy sposób komunikacji pomiędzy modułami komputera, to znaczy wszystkie urządzenia wejściowe i wyjściowe są połączone tymi samymi przewodami (szynami). To prototyp nowoczesnej magistrali systemowej.

- Zwiększona pojemność pamięci

. Bęben magnetyczny jest stopniowo zastępowany przez dyski magnetyczne wykonane w formie autonomicznych pakietów. Pojawiły się wyświetlacze i plotery.

Czwarta generacja komputerów

Okres ten okazał się najdłuższy – od końca lat 70. do chwili obecnej. Charakteryzuje się wszelkiego rodzaju innowacjami prowadzącymi do znaczących zmian. Jednak kardynalne, rewolucyjne zmiany, które pozwalają mówić o zmianie w tej generacji komputerów, jeszcze nie nastąpiły. Chociaż jeśli porównamy komputery na przykład z początku lat 80. i dzisiejsze, to znacząca różnica jest oczywista.

Na szczególną uwagę zasługuje jeden z najważniejszych pomysłów realizowanych w komputerze na tym etapie: wykorzystanie kilku procesorów jednocześnie do obliczeń (przetwarzanie wieloprocesorowe). Zmianom uległa także konstrukcja komputera.

Nowe technologie tworzenia układów scalonych umożliwiły opracowanie na przełomie lat 70. i 80. komputerów czwartej generacji opartych na wielkoskalowych układach scalonych (LSI), których stopień integracji wynosi dziesiątki i setki tysięcy elementów na pojedyńczy czip. Największą zmianą w technologii obliczeń elektronicznych związaną ze stosowaniem LSI było stworzenie mikroprocesorów. Obecnie okres ten uważany jest za rewolucję w przemyśle elektronicznym. Pierwszy mikroprocesor został stworzony przez firmę Intel w 1971 roku. Na jednym chipie można było zbudować procesor z minimalną ilością sprzętu, zawierający 2250 tranzystorów.

Pojawienie się mikroprocesora wiąże się z jednym z najważniejszych wydarzeń w historii informatyki - powstaniem i użytkowaniem komputerów osobistych (rysunek 24.11), co wpłynęło nawet na terminologię. Stopniowo mocno zakorzeniony termin „komputer” został zastąpiony znanym już słowem „komputer”, a technologię komputerową zaczęto nazywać technologią komputerową.

Ryż. 24.11. Komputer osobisty

Początek powszechnej sprzedaży komputerów osobistych kojarzony jest z nazwiskami S. Jobsa i V. Woźniaka, założycieli firmy Apple Computer, która w 1977 roku rozpoczęła produkcję komputerów osobistych Apple. W komputerach tego typu za podstawę przyjęto zasadę stworzenia „przyjaznego” środowiska pracy człowieka na komputerze, gdy przy tworzeniu oprogramowania jednym z głównych wymagań było zapewnienie użytkownikowi wygodnej pracy. Komputer zwrócił się w stronę mężczyzny. Dalsze jego udoskonalanie przeprowadzono z myślą o wygodzie użytkownika. Jeśli wcześniej przy obsłudze komputerów wdrożono zasadę scentralizowanego przetwarzania informacji, gdy użytkownicy skupiali się wokół jednego komputera, to wraz z pojawieniem się komputerów osobistych nastąpił ruch odwrotny - decentralizacja, gdy jeden użytkownik może korzystać z komputerów. pracować z kilkoma

Od 1982 roku w IBM rozpoczęła produkcję modelu komputera osobistego, który na wiele lat stał się standardem. IBM udostępnił dokumentację sprzętu i specyfikacje oprogramowania, umożliwiając innym firmom opracowywanie zarówno sprzętu, jak i oprogramowania. W ten sposób pojawiły się rodziny (klony) „dubletów” komputerów osobistych IBM.

W 1984 roku przez IBM powstał komputer osobisty oparty na mikroprocesorze Intel 80286 z autobusem architektonicznym standard branżowy - ISA(Przemysłowa architektura standardowa). Od tego czasu rozpoczęła się zacięta konkurencja pomiędzy kilkoma korporacjami produkującymi komputery osobiste. Jeden typ procesora zastępowano innym, co często wymagało dodatkowych znaczących modernizacji, a czasem nawet całkowitej wymiany komputerów. Wyścig w poszukiwaniu coraz bardziej zaawansowanych parametrów technicznych wszystkich urządzeń komputerowych trwa do dziś. Co roku konieczne jest przeprowadzenie radykalnej modernizacji istniejącego komputera.

Ogólna własność rodziny IBM PC- kompatybilność oprogramowania od dołu do góry i zasada otwartej architektury, która zapewnia możliwość dodawania istniejącego sprzętu bez usuwania starego lub modyfikowania go bez wymiany całego komputera.

Nowoczesne komputery przewyższa komputery poprzednich generacji pod względem zwartości, ogromnych możliwości i dostępności dla różnych kategorii użytkowników.

Komputery czwartej generacji rozwijają się w dwóch kierunkach, co zostanie omówione w kolejnych tematach tego rozdziału. Pierwszy kierunek- tworzenie wieloprocesorowych systemów obliczeniowych. Drugi- produkcja tanich komputerów osobistych zarówno stacjonarnych, jak i przenośnych oraz na ich bazie sieci komputerowych.

Pytania testowe i zadania

1. Opowiedz nam o historii rozwoju komputerów przed pojawieniem się komputerów.

2. Czym jest pokolenie komputerów i co powoduje zmianę pokoleń?

3. Opowiedz nam o pierwszej generacji komputerów.

4. Opowiedz nam o drugiej generacji komputerów.

5. Opowiedz nam o trzeciej generacji komputerów.

6. Opowiedz nam o czwartej generacji komputerów.

7. Kiedy i dlaczego nazwę „komputer” zaczęto stopniowo zastępować terminem „komputer”?

8. Co rozsławiło matematyka Johna von Neumanna?

Perspektywy rozwoju systemów komputerowych

Po przestudiowaniu tego tematu dowiesz się:

Jakie są główne kierunki rozwoju komputerów;

- jakie są przyczyny tych trendów.

|

|

Znając funkcjonalność komputerów, można zastanowić się nad perspektywami ich rozwoju. Nie jest to zadanie zbyt satysfakcjonujące, szczególnie w odniesieniu do technologii komputerowej, gdyż w żadnej innej dziedzinie tak istotne zmiany nie zachodzą w tak krótkim czasie. Niemniej jednak istota rozwoju technologii komputerowej jest następująca: po pierwsze, przed ludźmi otwiera się pewien stosunkowo nowy obszar wykorzystania komputerów, jednak aby wdrożyć te pomysły, potrzebne są nowe, zaawansowane technologicznie możliwości komputerów. Po opracowaniu i wdrożeniu niezbędnych technologii natychmiast stają się widoczne inne obiecujące obszary zastosowań komputerów itp.

Na przykład firma Fujitsu opracowała uniwersalnego robota tragarskiego. W hotelowym lobby robot wita gości ochrypłym barytonowym głosem. Po podaniu numeru pokoju robot bierze w obie „ręce” ciężkie walizki lub wytacza wózek i rusza w stronę windy, po czym wciska przycisk przywołania windy, podnosi się na piętro i eskortuje gości do pokoju. Elektroniczna mapa hotelu, osiem kamer i czujniki ultradźwiękowe pozwalają robotowi pokonać wszelkie przeszkody. Prawe i lewe koła obracają się niezależnie, dzięki czemu poruszanie się po pochyłych i nierównych powierzchniach jest łatwe. Wykorzystując system przetwarzania obrazu 3D, robot może podnosić przedmioty i przekazywać je gościom. Robot jest wrażliwy na instrukcje głosowe i ma połączenie z Internetem. Informacje o hotelu można uzyskać na kolorowym ekranie dotykowym. W nocy robot patroluje hotelowe korytarze.

Na przykład w Massachusetts Institute of Technology (USA) zademonstrowano modele odzieży z wbudowanymi komputerami i urządzeniami elektronicznymi. Dziś nowy trend nazywa się „cyber modą”. Cyberbroszka zdobiąca sukienkę na tej ilustracji to nie tylko dodatek – to urządzenie elektroniczne, które miga w rytm bicia serca swojej właścicielki.

Można przypuszczać, że w przyszłości będą działać setki aktywnych urządzeń komputerowych, które będą śledzić nasz stan i położenie, łatwo odbierać nasze informacje i sterować sprzętem AGD. Nie będą w jednej wspólnej „skorupie”. Będą wszędzie. Perspektywy rozwoju takich urządzeń komputerowych: staną się znacznie mniejsze i będą miały niski koszt.

Zastanówmy się nad perspektywami i trendami rozwoju technologii komputerowej służącej do świadczenia usług informacyjnych i zarządzania. Każdy komputer nie tylko potrafi dokładnie i szybko liczyć, ale także stanowi pojemny magazyn informacji. Obecnie coraz częściej wykorzystywana jest najbardziej specyficzna funkcja komputerów, czyli informacja, i jest to jedna z przyczyn nadchodzącej „powszechnej informatyzacji”. Zazwyczaj informacje są przygotowywane na komputerze, następnie drukowane i rozpowszechniane w tej formie.

Jednak już na początku XXI wieku spodziewana jest zmiana podstawowego środowiska informacyjnego – ludzie zaczną otrzymywać większość informacji nie za pośrednictwem tradycyjnych kanałów komunikacji – radia, telewizji, druku, ale za pośrednictwem sieci komputerowych.

Już dzisiaj można zaobserwować zmianę celu korzystania z komputerów. Wcześniej komputery służyły wyłącznie do wykonywania różnorodnych obliczeń naukowych, technicznych i ekonomicznych, a obsługiwały je użytkownicy z ogólnym przeszkoleniem komputerowym oraz programiści.

Wraz z pojawieniem się telekomunikacji zakres wykorzystania komputerów przez użytkowników radykalnie się zmienia. Zapotrzebowanie na telekomunikację komputerową stale rośnie. Coraz więcej osób korzysta z Internetu, aby znaleźć rozkłady jazdy pociągów lub najświeższe wiadomości z Dumy, zapoznać się z artykułem naukowym kolegi, dokonać wyboru, gdzie spędzić wolny wieczór itp. Tego rodzaju informacji każdy potrzebuje w każdym momencie czasie i w dowolnym miejscu.

Obecnie opracowywana jest nowa koncepcja rozwoju Internetu - utworzenie sieci semantycznej. Jest to dodatek do istniejącej sieci WWW i ma na celu uczynienie informacji zamieszczanych w sieci bardziej zrozumiałymi dla komputerów. Od 1999 roku projekt Semantic Web rozwija się pod patronatem Konsorcjum World Wide Web.

Obecnie komputery odgrywają raczej ograniczoną rolę w generowaniu i przetwarzaniu informacji w Internecie. Funkcje komputerów ograniczają się głównie do przechowywania, wyświetlania i wyszukiwania informacji. Wynika to z faktu, że większość informacji w Internecie ma formę tekstową, a komputery nie są w stanie dostrzec i zrozumieć informacji semantycznych. Tworzenie informacji, jej ocena, klasyfikacja i aktualizacja – tym wszystkim w dalszym ciągu zajmuje się człowiek.

Powstaje pytanie – jak sprawić, by komputery zrozumiały znaczenie informacji zamieszczanych w sieci i nauczyły z nich korzystać? Jeśli nie można jeszcze nauczyć komputera rozumienia języka ludzkiego, konieczne jest stworzenie języka, który byłby dla niego zrozumiały. Idealnie byłoby, gdyby wszystkie informacje w Internecie były publikowane w dwóch językach: języku zrozumiałym dla ludzi i języku zrozumiałym dla komputerów. Aby stworzyć przyjazny komputerowi opis zasobu sieciowego w sieci semantycznej, stworzono format RDF (Resource Opis Framework). Jest przeznaczony do przechowywania metadanych (metadane to dane o danych) i nie jest przeznaczony do czytania ani wykorzystywania przez ludzi. Opisy w formacie RDF muszą być dołączone do każdego zasobu sieciowego i przetwarzane automatycznie przez komputer.

Sieć semantyczna zapewnia dostęp do przejrzyście ustrukturyzowanych informacji dla dowolnej aplikacji, niezależnie od platformy i języka programowania. Programy będą mogły same znajdować niezbędne zasoby, przetwarzać informacje, podsumowywać dane, identyfikować powiązania logiczne, wyciągać wnioski, a nawet podejmować decyzje na podstawie tych wniosków. Sieć semantyczna, jeśli zostanie powszechnie przyjęta i mądrze wdrożona, może wywołać rewolucję w Internecie.

Sieć semantyczna to koncepcja sieci, w której każdy zasób informacji w języku ludzkim musi być opatrzony opisem zrozumiałym dla komputera.

Aby móc wejść do sieci komputerowej, komputer musi być w pełni mobilny i wyposażony w radiomodem. W przyszłości komputery przenośne powinny stać się bardziej miniaturowe i zapewniać wydajność porównywalną z wydajnością nowoczesnych superkomputerów. Muszą mieć płaski wyświetlacz o dobrej rozdzielczości. Ich zewnętrzne nośniki danych – dyski magnetyczne – o niewielkich rozmiarach będą miały pojemność ponad 100 GB. Aby komunikować się z komputerem w języku naturalnym, będzie on szeroko wyposażony w multimedia, przede wszystkim audio i wideo.

Aby zapewnić wysoką jakość i powszechną wymianę informacji między komputerami, zastosowane zostaną zasadniczo nowe metody komunikacji:

♦ kanały podczerwieni w zasięgu wzroku;

♦ kanały telewizyjne;

♦ bezprzewodowa technologia szybkiej komunikacji cyfrowej.

Umożliwi to budowę systemów ultraszybkich autostrad informacyjnych, łączących ze sobą wszystkie istniejące systemy.

Obszary zastosowań komputerów stale się poszerzają, a każdy z nich wyznacza nowy trend w rozwoju technologii komputerowej. W przyszłości wszystkie kompleksy i systemy obliczeniowe, od superkomputerów po komputery osobiste, staną się elementami jednej sieci komputerowej. A przy tak złożonej rozproszonej strukturze należy zapewnić praktycznie nieograniczoną przepustowość i szybkość przesyłania informacji.

Nowoczesne komputery półprzewodnikowe wkrótce wyczerpią swój potencjał i nawet wraz z przejściem na trójwymiarową architekturę chipów ich prędkość będzie ograniczona do 1015 operacji na sekundę. Poszukiwania nowych sposobów udoskonalenia komputerów prowadzone są w wielu kierunkach. Istnieje kilka możliwych alternatyw dla zastąpienia nowoczesnych komputerów – komputery kwantowe, komputery neuronowe i komputery optyczne. Przy opracowywaniu „komputerów przyszłości” wykorzystuje się szeroki zakres dyscyplin naukowych: elektronikę molekularną, biologię molekularną, robotykę, mechanikę kwantową, chemię organiczną itp. Rozważmy główne cechy tych komputerów.

Komputer optyczny. W komputerach optycznych nośnikiem informacji jest strumień światła. Zastosowanie promieniowania optycznego jako nośnika informacji ma szereg zalet w porównaniu z sygnałami elektrycznymi:

♦ prędkość propagacji sygnału świetlnego jest większa niż prędkość sygnału elektrycznego;

♦ strumienie światła, w przeciwieństwie do elektrycznych, mogą się ze sobą krzyżować;

♦ strumienie świetlne mogą być przepuszczane przez wolną przestrzeń;

♦ możliwość tworzenia architektur równoległych.

Główną zaletą komputerów optycznych jest tworzenie większej liczby architektur równoległych w porównaniu z tradycyjnymi komputerami elektronicznymi, które pozwalają pokonać ograniczenia w szybkości i równoległym przetwarzaniu informacji. Technologie optyczne są ważne nie tylko dla tworzenia komputerów optycznych, ale także dla komunikacji optycznej i Internetu.

Neurokomputer. Aby rozwiązać niektóre problemy, konieczne jest stworzenie skutecznego systemu sztucznej inteligencji, który byłby w stanie przetwarzać informacje bez wydawania dużych zasobów obliczeniowych. Doskonałym analogiem do rozwiązania takiego problemu może być mózg i układ nerwowy organizmów żywych, które umożliwiają wydajne przetwarzanie informacji sensorycznych. Ludzki mózg składa się z 10 miliardów komórek nerwowych – neuronów. Podobnie powinien być zbudowany neurokomputer modelujący funkcje neuronów.

Pojawienie się neurokomputerów, często nazywanych biokomputerami, w dużej mierze wiąże się z rozwojem nanotechnologii, do którego aktywnie dążą naukowcy w wielu krajach. Neurokomputery mają być budowane w oparciu o neurochipy (sztuczne neurony) i połączenia neuronopodobne, które są funkcjonalnie zorientowane na konkretny algorytm, aby rozwiązać konkretny problem. Dlatego do rozwiązywania problemów różnego typu wymagana jest sieć neuronowa o różnych topologiach (odmianach połączeń neurochipów). Jeden sztuczny neuron może być wykorzystany w kilku algorytmach przetwarzania informacji w sieci, a każdy algorytm jest realizowany przy użyciu pewnej liczby sztucznych neuronów. Sieć neuronowa (perceptron) może uczyć się rozpoznawania wzorców.

Obietnica stworzenia neurokomputerów polega na tym, że sztuczne struktury, które mają właściwości mózgu i układu nerwowego, mają szereg ważnych cech: równoległe przetwarzanie informacji, zdolność uczenia się, zdolność automatycznej klasyfikacji, wysoka niezawodność, asocjatywność.

Komputer kwantowy. Działanie komputera kwantowego opiera się na prawach mechaniki kwantowej. Mechanika kwantowa pozwala ustalić sposób opisu i prawa ruchu mikrocząstek (atomów, cząsteczek, jąder atomowych) i ich układów. Prawa mechaniki kwantowej stanowią podstawę badania struktury materii. Umożliwiły wyjaśnienie budowy atomów, ustalenie natury wiązań chemicznych, wyjaśnienie układu okresowego pierwiastków, zrozumienie budowy jąder atomowych i badanie właściwości cząstek elementarnych.

Fizyczna zasada działania komputera kwantowego opiera się na zmianie energii atomu. Posiada dyskretny ciąg wartości EQ, EI,... En, zwany widmem energii atomu. Emisja i absorpcja energii elektromagnetycznej przez atom zachodzi w odrębnych porcjach - kwantach, czyli fotonach. Kiedy foton jest absorbowany, energia atomu wzrasta i następuje przejście z niższego do górnego poziomu, a gdy foton jest emitowany, następuje odwrotne przejście w dół.

Dlatego też wprowadzono pojęcie „kubitu” (kubit, bit kwantowy) jako podstawowej jednostki komputera kwantowego, analogicznie do komputera tradycyjnego, w którym używane jest pojęcie „bitu”. Wiadomo, że bit ma tylko dwa stany – 0 i 1, natomiast stanów kubitu jest znacznie więcej. Dlatego do opisu stanu układu kwantowego wprowadzono pojęcie funkcji falowej w postaci wektora o dużej liczbie wartości.

Dla komputerów kwantowych, podobnie jak dla klasycznych, wprowadzono elementarne kwantowe operacje logiczne: alternatywę, koniunkcję i negację, za pomocą których zostanie zorganizowana cała logika komputera kwantowego. Tworząc komputer kwantowy, główną uwagę poświęca się zagadnieniom sterowania kubitami za pomocą emisji wymuszonej i zapobieganiu emisji spontanicznej, która zakłóci pracę całego układu kwantowego.

Można założyć, że połączenie komputerów kwantowych, optycznych i neuronowych da światu potężny hybrydowy system obliczeniowy. System taki od konwencjonalnego będzie się wyróżniał ogromną produktywnością (około 1051), wynikającą z równoległości działań, a także możliwością efektywnego przetwarzania i zarządzania informacją sensoryczną. Produkcja „komputerów przyszłości” będzie wymagała znacznych kosztów ekonomicznych, kilkadziesiąt razy wyższych niż koszty produkcji nowoczesnych komputerów półprzewodnikowych.

Tabela 28.1 przedstawia ogólne tendencje zmian charakterystyk technologii komputerowej, biorąc pod uwagę główne obszary zastosowań zarówno nowoczesnych, jak i perspektywicznych komputerów.

Tabela 28.1. Trendy w wydajności komputerów

Pytania testowe i zadania

1. Jaki jest związek pomiędzy celem korzystania z komputera a rozwojem technologii komputerowej?

2. Podaj przykłady obiecujących zastosowań komputerów.

3. Na czym skupiają się obiecujące systemy komputerowe?

4. Jak wyobrażasz sobie przyszłość technologii komputerowej?

5. Na jakich wartościach parametrów technicznych komputerów możemy się skupić w najbliższej przyszłości?

6. Jaki jest cel sieci semantycznej?

7. Dlaczego komputery powstają w oparciu o różne zasady działania?

8. Jaka jest główna idea stworzenia komputera optycznego?

9. Jaka jest główna idea stworzenia neurokomputera?

10. Jaka jest główna idea stworzenia komputera kwantowego?

Krótką historię technologii komputerowej można podzielić na kilka okresów ze względu na to, z jakich podstawowych elementów zbudowano komputer. Podział czasu na okresy jest w pewnym stopniu arbitralny, gdyż Kiedy jeszcze produkowano komputery starej generacji, nowa generacja zaczynała zyskiwać na popularności.

Można wyróżnić ogólne trendy w rozwoju komputerów:

- Zwiększenie liczby elementów na jednostkę powierzchni.

- Redukcja.

- Zwiększona prędkość pracy.

- Zmniejszony koszt.

- Z jednej strony rozwój oprogramowania, z drugiej upraszczanie, standaryzacja sprzętu.

Pokolenie zerowe. Komputery mechaniczne

Warunki wstępne pojawienia się komputera kształtowały się prawdopodobnie od czasów starożytnych, ale przegląd często zaczyna się od maszyny liczącej Blaise'a Pascala, którą zaprojektował w 1642 roku. Maszyna ta mogła wykonywać jedynie operacje dodawania i odejmowania. W latach 70. tego samego wieku Gottfried Wilhelm Leibniz zbudował maszynę, która potrafiła wykonywać operacje nie tylko dodawania i odejmowania, ale także mnożenia i dzielenia.

W XIX wieku Charles Babbage wniósł ogromny wkład w przyszły rozwój technologii komputerowej. Jego różnica silnika, chociaż potrafiła tylko dodawać i odejmować, wyniki obliczeń wytłaczano na miedzianej płycie (analog środka wprowadzania i wyprowadzania informacji). Później opisane przez Babbage'a silnik analityczny musiał wykonać wszystkie cztery podstawowe operacje matematyczne. Silnik analityczny składał się z pamięci, mechanizmu obliczeniowego oraz urządzeń wejścia/wyjścia (podobnie jak komputer... tylko mechaniczny), a co najważniejsze, potrafił wykonywać różne algorytmy (w zależności od tego, która karta dziurkowana znajdowała się w urządzeniu wejściowym). Programy dla silnika analitycznego napisała Ada Lovelace (pierwsza znana programistka). W rzeczywistości samochód nie został wówczas zrealizowany ze względu na trudności techniczne i finansowe. Świat pozostawał w tyle za tokiem myślenia Babbage’a.

W XX wieku automatyczne maszyny liczące projektowali Konrad Zus, George Stibits i John Atanasov. Maszyna tego ostatniego zawierała, można rzec, prototypową pamięć RAM i wykorzystywała także arytmetykę binarną. Komputery przekaźnikowe Mark I i Mark II Howarda Aikena miały podobną architekturę do silnika analitycznego Babbage'a.

Pierwsza generacja. Komputery lampowe (194x-1955)

Wydajność: kilkadziesiąt tysięcy operacji na sekundę.

Osobliwości:

- Ponieważ lampy są znacznych rozmiarów, a jest ich tysiące, maszyny były ogromne.

- Ponieważ lamp jest dużo i mają tendencję do przepalania, komputer często pozostawał bezczynny z powodu wyszukiwania i wymiany uszkodzonej lampy.

- Lampy emitują dużą ilość ciepła, dlatego komputery wymagają specjalnych, wydajnych systemów chłodzenia.

Przykłady komputerów:

Kolos- tajny rozwój rządu brytyjskiego (w rozwoju brał udział Alan Turing). To pierwszy na świecie komputer elektroniczny, choć nie wpłynął na rozwój techniki komputerowej (ze względu na swoją tajemnicę), ale pomógł wygrać II wojnę światową.

Eniak. Twórcy: John Mauchley i J. Presper Eckert. Waga maszyny wynosi 30 ton. Wady: użycie systemu dziesiętnego; Mnóstwo przełączników i kabli.

Edsak. Osiągnięcie: pierwsza maszyna z programem w pamięci.

Wichura I. Krótkie słowa, praca w czasie rzeczywistym.

Komputer 701(i kolejne modele) firmy IBM. Pierwszy komputer, który przewodzi na rynku od 10 lat.

Drugie pokolenie. Komputery tranzystorowe (1955-1965)

Wydajność: setki tysięcy operacji na sekundę.

W porównaniu do lamp próżniowych zastosowanie tranzystorów pozwoliło zmniejszyć rozmiar sprzętu komputerowego, zwiększyć niezawodność, zwiększyć prędkość działania (do 1 miliona operacji na sekundę) i prawie wyeliminować przenoszenie ciepła. Rozwijają się metody przechowywania informacji: powszechnie stosowana jest taśma magnetyczna, a później pojawiają się dyski. W tym okresie pojawiła się pierwsza gra komputerowa.

Pierwszy komputer tranzystorowy Teksas stał się prototypem komputerów branżowych PDP Firmy DEC, które można uznać za założycieli branży komputerowej, gdyż pojawiło się zjawisko masowej sprzedaży maszyn. DEC wypuszcza pierwszy minikomputer (wielkości szafki). Wykryto wyświetlacz.

Aktywnie działa również IBM, produkując tranzystorowe wersje swoich komputerów.

Komputer 6600 CDC, opracowane przez Seymoura Craya, miało przewagę nad innymi komputerami tamtych czasów - swoją szybkością, którą osiągano poprzez równoległe wykonywanie poleceń.

Trzecia generacja. Komputery z układami scalonymi (1965-1980)

Wydajność: miliony operacji na sekundę.

Układ scalony to obwód elektroniczny wyryty na chipie krzemowym. Tysiące tranzystorów mieści się w takim obwodzie. W rezultacie ta generacja komputerów została zmuszona stać się jeszcze mniejsza, szybsza i tańsza.

Ta ostatnia właściwość umożliwiła komputerom penetrację różnych obszarów ludzkiej działalności. Z tego powodu stały się bardziej wyspecjalizowane (tj. istniały różne komputery do różnych zadań).

Pojawił się problem dotyczący kompatybilności produkowanych modeli (oprogramowanie do nich). Po raz pierwszy IBM przyłożył dużą wagę do kompatybilności.

Zaimplementowano wieloprogramowość (dzieje się tak, gdy w pamięci znajduje się kilka programów wykonywalnych, co skutkuje oszczędnością zasobów procesora).

Dalszy rozwój minikomputerów ( PDP-11).

Czwarta generacja. Komputery na wielkoskalowych (i bardzo dużych) układach scalonych (1980-...)

Wydajność: setki milionów operacji na sekundę.

Możliwe stało się umieszczenie nie jednego układu scalonego na jednym chipie, ale ich tysiące. Szybkość komputerów znacznie wzrosła. Komputery nadal stawały się tańsze i teraz kupowały je nawet osoby prywatne, co zapoczątkowało tzw. erę komputerów osobistych. Ale ta osoba najczęściej nie była zawodowym programistą. W związku z tym niezbędny był rozwój oprogramowania, aby człowiek mógł korzystać z komputera zgodnie ze swoją wyobraźnią.

Pod koniec lat 70. i na początku 80. popularne były komputery Jabłko, opracowany przez Steve'a Jobsa i Steve'a Wozniaka. Później komputer osobisty został wprowadzony do masowej produkcji Komputer IBM na procesorze Intel.

Później pojawiły się procesory superskalarne, zdolne do wykonywania wielu instrukcji jednocześnie, oraz komputery 64-bitowe.

Piąte pokolenie?

Obejmuje to nieudany japoński projekt (dobrze opisany w Wikipedii). Inne źródła określają piątą generację komputerów jako tzw. komputery niewidzialne (mikrokontrolery wbudowane w sprzęt AGD, samochody itp.) lub komputery kieszonkowe.

Istnieje również opinia, że w piątej generacji powinny znaleźć się komputery z procesorami dwurdzeniowymi. Z tego punktu widzenia piąta generacja rozpoczęła się około 2005 roku.

Miejska placówka oświatowa

Szkoła średnia nr 1 Sadovskaya

Okręg miejski Anninsky

Region Woroneża

Przedmiot: informatyka i ICT

Praca pisemna

„Historia rozwoju

technologia komputerowa"

Wykonawca:

uczennica klasy IX „A”.

Łukin Aleksander Aleksandrowicz

Kierownik:

Demczenkowa Oksana Evgenievna,

nauczyciel informatyki i informatyki

Sadowoe, 2010

Spis treści

1. Wprowadzenie………………………………………………………3

2. Liczenie urządzeń przed pojawieniem się komputerów………………………... 4

1.1. Okres przedmechaniczny…………………………………. 4

1.1.1. Liczydło na palcach………………………………….. 4

1.1.2. Liczydło na kamieniach…………………………………4

1.1.3. Konto w liczydle ………………………………………….4

1.1.4. Laski Napiera…………………………………..5

1.1.5. Suwak logarytmiczny……………………………5

1.2. Okres mechaniczny……………………………………………………..6

1.2.1. Maszyna Blaise’a Pascala……………………………..6

1.2.2. Maszyna Gottfrieda Leibniza …………………………7

1.2.3. Karty dziurkowane Jaccard ………………………………… 7

1.2.4. Silnik różnicowy Charlesa Babbage’a……………8

1.2.5. Hermana Holleritha…………………………………9

1.2.6. Konrad Zuse………………………......9

1.2.7. Howard Aiken……………………………………….10

3. Okres rozliczeń elektronicznych……………………………11

2.1. Komputery analogowe (AVM) …………….11

2.2. Komputery elektroniczne (komputery) …………...11

2.2.1. I generacja komputerów…………………………………..12

2.2.2. II generacja komputerów………………………………….13

2.2.3. III generacja komputerów…………………………………...15

2.2.4. IV generacja komputerów…………………………………16

2.2.5. V generacja komputerów………………………………….17

2.3. Komputery analogowo-cyfrowe (ADCM) .....18

4. Zakończenie……………………………………………………….. 19

5. Referencje……………………………………………………………20

Wstęp

Słowo „komputer” oznacza „komputer”, tj. urządzenie komputerowe. Potrzeba automatyzacji przetwarzania danych, w tym obliczeń, pojawiła się już dawno temu. Ponad 1500 lat temu do liczenia używano patyków, kamyków itp.

Ten temat jest istotny. Ponieważ komputery objęły wszystkie obszary działalności człowieka. W dzisiejszych czasach trudno sobie wyobrazić, że można obejść się bez komputerów. Ale nie tak dawno temu, bo aż do początku lat 70., komputery były dostępne dla bardzo ograniczonego kręgu specjalistów, a ich użycie z reguły pozostawało owiane tajemnicą i mało znane ogółowi społeczeństwa. Jednak w 1971 roku miało miejsce wydarzenie, które radykalnie zmieniło sytuację i z fantastyczną szybkością zamieniło komputer w narzędzie codziennej pracy dla dziesiątek milionów ludzi. W tym niewątpliwie znaczącym roku prawie nieznana firma Intel z małego amerykańskiego miasteczka o pięknej nazwie Santa Clara (Kalifornia) wypuściła pierwszy mikroprocesor. To jemu zawdzięczamy pojawienie się nowej klasy systemów informatycznych – komputerów osobistych, z których korzystają obecnie w zasadzie wszyscy, od uczniów szkół podstawowych i księgowych po naukowców i inżynierów.

W XXI wieku nie sposób wyobrazić sobie życia bez komputera osobistego. Komputer na stałe wkroczył w nasze życie, stając się głównym pomocnikiem człowieka. Dziś na świecie istnieje wiele komputerów różnych firm, o różnej grupie złożoności, przeznaczeniu i generacji.

W pracy tej staram się dać dość szeroki obraz historii rozwoju techniki komputerowej.

Celem mojej pracy jest zatem rozważenie rozwoju techniki komputerowej od czasów starożytnych do współczesności, a także dokonanie krótkiego przeglądu urządzeń liczących, począwszy od okresu przedmechanicznego, a skończywszy na współczesnych komputerach.

Liczenie urządzeń przed pojawieniem się komputerów

Okres przedmechaniczny

Liczydło na palcach

Przez cały czas ludzie musieli liczyć. Możemy tylko spekulować, kiedy ludzkość nauczyła się liczyć. Możemy jednak śmiało powiedzieć, że do prostego liczenia nasi przodkowie używali palców, a metodę tę z powodzeniem stosujemy do dziś. Co jednak zrobić, jeśli chcemy zapamiętać wyniki obliczeń lub policzyć coś więcej niż tylko palce? W takim przypadku możesz wykonać nacięcia na drewnie lub kości. Najprawdopodobniej tak właśnie postępowali pierwsi ludzie, o czym świadczą wykopaliska archeologiczne. Być może najstarszym znalezionym tego typu narzędziem jest kość z nacięciami, znaleziona w starożytnej osadzie Dolní Vestonici w południowo-wschodnich Czechach na Morawach. Przedmiot ten, zwany „kością z Westoniki”, był rzekomo używany już 30 tysięcy lat przed naszą erą. mi. Pomimo tego, że u zarania cywilizacji ludzkiej wynaleziono już dość skomplikowane systemy rachunku różniczkowego, użycie szeryfów do liczenia trwało dość długo. Liczenie palców jest niewątpliwie najstarszą i najprostszą metodą liczenia. Dla wielu narodów palce pozostają narzędziem do liczenia na wyższych poziomach rozwoju. Do tych ludów należeli Grecy, dla których liczenie na palcach przez bardzo długi czas było praktycznym środkiem.

Liczydło na kamieniach

Aby ułatwić liczenie, prymitywny człowiek zaczął używać małych kamieni zamiast palców. Zbudował piramidę z kamieni i określił, ile jest w niej kamieni, ale jeśli liczba była duża, trudno było policzyć liczbę kamieni na oko. Dlatego zaczął budować mniejsze piramidy tej samej wielkości z kamieni, a ponieważ na jego rękach było dziesięć palców, piramida składała się z dokładnie dziesięciu kamieni.

Konto na Abacusie

W czasach starożytnych kultur ludzie musieli rozwiązywać problemy związane z kalkulacjami handlowymi, obliczaniem czasu, określaniem powierzchni ziemi itp. Wzrost objętości tych obliczeń doprowadził nawet do tego, że specjalnie przeszkolone osoby, dobrze zaznajomione z technikami obliczeń arytmetycznych, były zapraszane z jednego kraju do drugiego. Dlatego prędzej czy później musiały pojawić się urządzenia, które ułatwiały codzienne obliczenia.

Tak więc w starożytnej Grecji i starożytnym Rzymie stworzono urządzenia liczące zwane liczydłem (od greckiego słowa abakion - „tablica pokryta kurzem”). Liczydło jest również nazywane liczydłem rzymskim. Obliczenia na nich przeprowadzono poprzez przesuwanie kostek do liczenia i kamyków (kamienia) w zagłębieniach pasków desek wykonanych z brązu, kamienia, kości słoniowej i kolorowego szkła. Liczydło w swojej pierwotnej formie było deską (później przyjęło formę deski podzielonej przegrodami na kolumny). Narysowano na nim linie dzielące go na kolumny i w tych kolumnach umieszczono kamyki według tej samej zasady pozycjonowania, według której umieszcza się liczbę na naszym liczydle. Liczydła te przetrwały aż do renesansu.

W krajach starożytnego Wschodu (Chiny, Japonia, Indochiny) istniały chińskie liczydła. Na każdej nitce lub drucie tego liczydła znajdowało się pięć i dwa domino. Liczenie odbywało się w jednościach i piątkach.

W Rosji liczydło rosyjskie, które pojawiło się w XVI wieku, było używane do obliczeń arytmetycznych, ale w niektórych miejscach liczydło można spotkać do dziś.

Patyki Napiera

Pierwszym urządzeniem do wykonywania mnożenia był zestaw drewnianych klocków zwanych pałeczkami Napiera. Wynalazł je Szkot John Napier (1550-1617). Na takim zestawie drewnianych klocków umieszczono tabliczkę mnożenia. Ponadto John Napier wynalazł logarytmy.

Wynalazek ten pozostawił zauważalny ślad w historii wraz z wynalezieniem logarytmów przez Johna Napiera, o czym donosi publikacja z 1614 r. Jego tablice, których obliczenia wymagały dużo czasu, zostały później „wbudowane” w wygodne urządzenie, które znacznie przyspiesza przyspieszyć proces obliczeń - suwak logarytmiczny; został wynaleziony pod koniec lat dwudziestych XVII wieku. W 1617 roku Napier wymyślił inny sposób mnożenia liczb. Przyrząd, zwany „kostkami Napiera”, składał się z zestawu segmentowych prętów, które można było ustawić w taki sposób, że dodając liczby w odcinkach sąsiadujących ze sobą poziomo, otrzymaliśmy wynik ich mnożenia.

Teoria logarytmów Napiera miała znaleźć szerokie zastosowanie. Jednak jego „kostki” wkrótce zostały wyparte przez suwak logarytmiczny i inne urządzenia liczące, głównie mechaniczne, których pierwszym wynalazcą był genialny Francuz Blaise Pascal.

Władca logarytmiczny

Rozwój urządzeń liczących dotrzymywał kroku osiągnięciom matematyki. Wkrótce po odkryciu logarytmów w 1623 roku wynaleziono suwak logarytmiczny.

W 1654 r. Robert Bissacar, aw 1657 r. niezależnie S. Patridge (Anglia) opracowali prostokątny suwak logarytmiczny - jest to narzędzie liczące ułatwiające obliczenia, za pomocą którego operacje na liczbach zastępuje się operacjami na logarytmach tych liczby. Projekt linii w dużej mierze przetrwał do dziś.

Suwak logarytmiczny miał żyć długo: od XVII wieku do czasów współczesnych. Obliczenia za pomocą suwaka logarytmicznego są proste, szybkie, ale przybliżone. Dlatego nie nadaje się do dokładnych obliczeń, na przykład finansowych.

Szkic mechanicznego trzynastocyfrowego urządzenia sumującego z dziesięcioma kołami opracował Leonardo da Vinci (1452-1519). Na podstawie tych rysunków IBM zbudował teraz działającą maszynę do celów reklamowych.

Pierwszą mechaniczną maszynę liczącą skonstruował w 1623 roku profesor matematyki Wilhelm Schickard (1592-1636). Zmechanizowała operacje dodawania i odejmowania, a mnożenie i dzielenie wykonywano za pomocą elementów mechanizacji. Ale samochód Schickarda wkrótce spłonął w pożarze. Dlatego biografia mechanicznych urządzeń liczących zaczyna się od maszyny sumującej wykonanej w 1642 roku przez Blaise'a Pascala.

W 1673 roku inny wielki matematyk Gottfried Leibniz opracował urządzenie liczące, na którym można było już mnożyć i dzielić.

W 1880 r V.T. Odner tworzy w Rosji maszynę sumującą z przekładnią o zmiennej liczbie zębów, a w 1890 roku organizuje masową produkcję ulepszonych maszyn sumujących, co miało miejsce w pierwszej ćwierci XIX wieku. były głównymi maszynami matematycznymi, które znalazły zastosowanie na całym świecie. Ich modernizacja „Felix” była produkowana w ZSRR do lat 50-tych.

Pomysł stworzenia automatycznego komputera, który działałby bez interwencji człowieka, został po raz pierwszy wyrażony przez angielskiego matematyka Charlesa Babbage'a (1791-1864) na początku XIX wieku. W latach 1820-1822. zbudował maszynę, która potrafiła obliczać tablice wielomianów drugiego rzędu.

Uważa się, że pierwszą maszynę mechaniczną, która potrafiła dodawać i odejmować, wynaleziono w 1646 roku. młody 18-letni francuski matematyk i fizyk Blaise Pascal. Nazywa się „pascalina”.

Maszyna ta została zaprojektowana do pracy z liczbami 6-8 cyfrowymi i mogła jedynie dodawać i odejmować, a także miała lepszy sposób zapisywania wyniku niż wszystkie poprzednie. Maszyna Pascala mierzyła 36/13/8 centymetrów; to małe mosiężne pudełko było wygodne do przenoszenia. Miał kilka specjalnych uchwytów, za pomocą których odbywało się sterowanie, i miał kilka małych kółek z zębami. Pierwsze koło liczyło jednostki, drugie - dziesiątki, trzecie - setki itd. Dodawanie w maszynie Pascala odbywa się poprzez obrót kół do przodu. Przesuwając je do tyłu, wykonywane jest odejmowanie.

Chociaż „pascaline” wzbudził powszechny podziw, nie przyniósł bogactwa wynalazcy. Jednak wynaleziona przez niego zasada połączonych kół była podstawą, na której przez następne trzy stulecia zbudowano większość maszyn liczących. Idee inżynieryjne Pascala miały ogromny wpływ na wiele innych wynalazków w dziedzinie informatyki.

Główną wadą „pascaliny” była niedogodność wykonywania na niej wszystkich operacji, z wyjątkiem prostego dodawania. Pierwsza maszyna ułatwiająca odejmowanie, mnożenie i dzielenie została wynaleziona jeszcze w tym samym XVII wieku. w Niemczech. Zasługą na ten wynalazek jest Gottfried Wilhelm Leibniz.

Następnym krokiem było wynalezienie maszyny zdolnej do wykonywania mnożenia i dzielenia. Maszynę taką wynalazł w 1671 roku Niemiec Gottfried Leibniz. Podczas pobytu w Paryżu Leibniz spotkał holenderskiego matematyka i astronoma Christiana Huygensa. Widząc, ile obliczeń musi wykonać astronom, Leibniz postanowił wynaleźć urządzenie mechaniczne, które ułatwiłoby obliczenia. „Bo niegodne jest, aby tak cudowni ludzie, jak niewolnicy, tracili czas na prace komputerowe, które można powierzyć każdemu, kto obsługuje maszynę”.

Choć maszyna Leibniza była podobna do Pascaliny, posiadała ruchomą część i uchwyt, za pomocą którego można było obracać specjalne koło lub cylindry umieszczone wewnątrz aparatu. Mechanizm ten umożliwił przyspieszenie powtarzalnych operacji dodawania niezbędnych do mnożenia. Samopowtarzanie również odbywało się automatycznie.

W 1673 roku skonstruował kalkulator mechaniczny. Ale zasłynął przede wszystkim nie dzięki tej maszynie, ale dzięki stworzeniu rachunku różniczkowego i całkowego. Położył także podwaliny pod system liczb binarnych, który później znalazł zastosowanie w automatycznych urządzeniach liczących.

Kolejny etap rozwoju urządzeń liczących zdawał się, przynajmniej na początku, nie mieć nic wspólnego z liczbami. Przez cały XVIII w. We francuskich fabrykach jedwabiu prowadzono eksperymenty z różnymi mechanizmami sterującymi maszyną za pomocą perforowanej taśmy, perforowanych kart lub drewnianych bębnów. We wszystkich trzech systemach nić była podnoszona lub opuszczana w zależności od obecności lub braku dziurek – w ten sposób powstawał pożądany wzór tkaniny.

Francuski tkacz i mechanik Joseph Jacquard stworzył pierwszy przykład maszyny sterowanej poprzez wprowadzanie do niej informacji. W 1802 roku zbudował maszynę, która ułatwiła proces wytwarzania tkanin o skomplikowanych wzorach. Wykonując taką tkaninę, musisz podnieść lub obniżyć każdy z rzędów nici. Następnie krosno rysuje kolejną nić pomiędzy podniesionymi i opuszczonymi nitkami. Następnie każda z nitek jest w określonej kolejności opuszczana lub podnoszona i maszyna ponownie przepuszcza przez nie nić. Proces ten powtarza się wielokrotnie, aż do uzyskania pożądanej długości wzorzystej tkaniny. Aby utrwalić wzór na tkaninie, Jacquard wykorzystał rzędy dziurek na kartach. Jeśli użyto dziesięciu nitek, wówczas w każdym rzędzie karty było miejsce na dziesięć dołków. Karta została zamontowana na maszynie w urządzeniu wykrywającym dziury w karcie. Urządzenie to wykorzystywało sondy do sprawdzania każdego rzędu otworów na karcie.

Działanie maszyny zaprogramowano przy użyciu całej talii kart perforowanych, z których każda sterowała jednym ruchem wahadłowym. Informacje zawarte na karcie sterowały maszyną.

Ze wszystkich wynalazców minionych stuleci, którzy wnieśli taki czy inny wkład w rozwój technologii komputerowej, Anglik Charles Babbage był najbliżej stworzenia komputera we współczesnym znaczeniu.

W 1812 roku angielski matematyk Charles Babbage rozpoczął prace nad tzw. silnikiem różnicowym, który miał obliczać dowolne funkcje, w tym trygonometryczne, a także kompilować tabele. W 1822 roku Charles Babbage zbudował urządzenie liczące, które nazwał silnikiem różnicowym. Informacje na kartach zostały wprowadzone do tej maszyny. Maszyna wykorzystywała cyfrowe koła z zębami do wykonywania szeregu operacji matematycznych. Jednak z powodu braku funduszy maszyna ta nie została ukończona i została przekazana do Muzeum King's College w Londynie, gdzie przechowywana jest do dziś.

Jednak ta porażka nie powstrzymała Babbage'a i w 1834 roku rozpoczął nowy projekt - stworzenie silnika analitycznego, który miał wykonywać obliczenia bez interwencji człowieka. Aby to zrobić, musiała umieć wykonywać programy wprowadzane za pomocą kart dziurkowanych (karty wykonane z grubego papieru z informacjami drukowanymi za pomocą dziurek, jak na krosnach) oraz posiadać „magazyn” do przechowywania danych i wyników pośrednich (we współczesnej terminologii - pamięć). Od 1842 do 1848 Babbage ciężko pracował, korzystając z własnych środków. Silnik Analityczny w odróżnieniu od swojego poprzednika miał nie tylko rozwiązywać problemy matematyczne jednego, konkretnego rodzaju, ale także wykonywać różnorodne operacje obliczeniowe zgodnie z instrukcjami wydawanymi przez operatora. W rzeczywistości jest to nic innego jak pierwszy uniwersalny komputer programowalny. Jeśli jednak silnik różnicowy miał wątpliwe szanse powodzenia, silnik analityczny wyglądał zupełnie nierealistycznie. Zbudowanie go i oddanie do użytku było po prostu niemożliwe. W swojej ostatecznej formie wagon miał być nie mniejszy niż lokomotywa kolejowa. Jego wewnętrzną konstrukcję stanowiła chaotyczna mieszanina części ze stali, miedzi i drewna, mechanizmów zegarowych napędzanych silnikiem parowym. Najmniejsza niestabilność jakiejkolwiek najmniejszej części doprowadziłaby do stukrotnego wzrostu zakłóceń w innych częściach, a wtedy cała maszyna stałaby się bezużyteczna.

Niestety nie udało mu się dokończyć prac nad stworzeniem Silnika Analitycznego – okazał się on zbyt skomplikowany jak na ówczesną technologię. Ale zasługą Babbage'a jest to, że jako pierwszy zaproponował i częściowo wdrożył ideę przetwarzania sterowanego programowo. To właśnie silnik analityczny był w swej istocie prototypem współczesnego komputera.

W 1985 roku pracownicy Muzeum Nauki w Londynie postanowili w końcu dowiedzieć się, czy w ogóle możliwe jest zbudowanie komputera Babbage'a. Po kilku latach ciężkiej pracy wysiłki zostały uwieńczone sukcesem. W listopadzie 1991 roku, na krótko przed dwusetną rocznicą urodzin słynnego wynalazcy, silnik różnicowy po raz pierwszy przeprowadził poważne obliczenia.

Zaledwie 19 lat po śmierci Babbage’a jedna z zasad leżących u podstaw silnika analitycznego – użycie kart dziurkowanych – została zawarta w działającym urządzeniu. Był to tabulator statystyczny zbudowany przez Amerykanina Hermana Holleritha w celu przyspieszenia przetwarzania wyników amerykańskiego spisu ludności w 1890 roku.

Pod koniec XIX wieku. Powstały bardziej złożone urządzenia mechaniczne. Najważniejszym z nich było urządzenie opracowane przez Amerykanina Hermana Holleritha. Jego wyjątkowość polegała na tym, że jako pierwsza wykorzystała ideę kart perforowanych, a obliczenia przeprowadzono przy użyciu prądu elektrycznego. To połączenie sprawiło, że maszyna była tak wydajna, że w swoim czasie była szeroko stosowana. Na przykład podczas spisu ludności przeprowadzonego w USA w 1890 r. Hollerith przy pomocy swoich maszyn był w stanie w ciągu trzech lat wykonać to, co w ciągu siedmiu lat wykonałaby ręcznie znacznie większa liczba osób.

Dopiero 100 lat później maszyna Babbage'a przyciągnęła uwagę inżynierów. Pod koniec lat trzydziestych niemiecki inżynier Konrad Zuse opracował pierwszą binarną maszynę cyfrową, Z1. Szeroko stosowano przekaźniki elektromechaniczne, czyli przełączniki mechaniczne uruchamiane prądem elektrycznym. W 1941 roku Konrad Zuse stworzył Z3, maszynę całkowicie sterowaną programowo.

Druga wojna światowa dała duży impuls rozwojowi technologii komputerowej: wojsko amerykańskie potrzebowało komputera.

W 1944 roku Amerykanin Howard Aiken w jednym z przedsiębiorstw IBM zbudował komputer Mark-1, który był dość mocny jak na tamte czasy. W maszynie tej zastosowano elementy mechaniczne – koła liczące – do przedstawiania liczb, a do sterowania wykorzystano przekaźniki elektromechaniczne. Program do przetwarzania danych został wprowadzony z taśmy dziurkowanej. Wymiary: 15/2,5 m, 750 000 części. „Mark-1” mógł pomnożyć dwie 23-bitowe liczby w 4 sekundy.

Komputery IV generacji nie są powszechnie stosowane ze względu na swoją specyfikę. Stanowiło to zachętę do rozwoju komputerów piątej generacji, których rozwój stawiał przed sobą zupełnie inne zadania niż rozwój wszystkich poprzednich komputerów. Jeśli twórcy komputerów 1. - 4. generacji stanęli przed takimi zadaniami, jak zwiększenie produktywności w zakresie obliczeń numerycznych, osiągnięcie dużej pojemności pamięci, to głównymi zadaniami twórców komputerów 5. generacji było stworzenie sztucznej inteligencji maszyna (umiejętność wyciągania logicznych wniosków z przedstawionych faktów), możliwość wprowadzania informacji do komputera za pomocą głosu i różnorodnych obrazów. Umożliwi to komunikację z komputerem wszystkim użytkownikom, nawet tym, którzy nie mają specjalnej wiedzy w tym zakresie. Komputer będzie asystentem człowieka we wszystkich dziedzinach.

GENERACJA EVM

| CHARAKTERYSTYKA |

I pokolenie |

II generacja |

III generacja |

IV generacja |

| Lata użytkowania |

||||

| Główny element |

E-mail lampa |

Tranzystor |

||