A. S. Kusainova, B. S. Imasheva, K. K. Dosmambetova, L. Z. Karsakbaeva, G. A. Derbisalina, A. U. Baidusenova, A. A. Kauysheva, A. K. Eshmanova

ANALIZA WYNIKÓW BADAŃ PRÓBNYCH LEKARZY STAŻÓW

Państwowy Uniwersytet Medyczny w Karagandzie, Centrum Republikańskie innowacyjne technologie edukacja medyczna i nauka

W celu realizacji państwowego programu „Salamatty Kazachstan” Republikańskie Centrum Innowacyjnych Technologii Edukacji Medycznej i Nauki (RCITMOiN) wraz z Departamentem Zasobów Ludzkich i Nauki Ministerstwa Zdrowia Republiki Kazachstanu od dwóch lat ostatnie lata przeprowadził niezależne badania próbne lekarzy stażystów na uniwersytetach medycznych w Republice Kazachstanu.

Wcześniej absolwenci byli egzaminowani wyłącznie przez same uczelnie, dlatego często stosowano subiektywne podejście do oceny jakości kształcenia stażystów. Główną przyczyną stronniczo wysokich wskaźników był brak skutecznych mechanizmów zewnętrznej kontroli jakości edukacji. Jak pokazuje doświadczenie międzynarodowe, w krajach z wydajne systemy edukacja, nawet przy rosnącej decentralizacji, kontrola jakości pozostaje ściśle scentralizowana.

Ujednolicona niezależna kontrola zewnętrzna i monitorowanie jakości mogą mieć znaczący wpływ na poprawę jakości edukacji usługi edukacyjne w organizacjach zajmujących się edukacją medyczną.

W 2011 roku Ministerstwo Edukacji Republiki Kazachstanu dokonało zmian i uzupełnień w Ustawie Republiki Kazachstanu „O oświacie” do art. nr 55 z uzupełnieniami ust. 4, 5, 6 następującą treść:

„Zewnętrzna ocena osiągnięć edukacyjnych jest jednym z rodzajów niezależnego od organizacji monitorowania jakości edukacji. Zewnętrzna ocena osiągnięć edukacyjnych przeprowadzana jest w celu oceny jakości usług edukacyjnych oraz określenia poziomu opanowania przez uczniów treści edukacyjnych. programy nauczania, przewidziane w Państwowym Standardzie Szkolnictwa Wyższego.”

Zgodnie z Państwowym Programem Rozwoju Edukacji Republiki Kazachstanu na lata 2011-2020. wprowadzony zostanie system zewnętrznej oceny osiągnięć edukacyjnych uczniów (EAEA). Planuje się, że postępowanie zostanie przeprowadzone z wykorzystaniem badań komputerowych z wykorzystaniem nowych technologii informatycznych. Ten system wprowadza się w celu oceny jakości usług edukacyjnych i określenia poziomu opanowania przez uczniów programów edukacyjnych.

Przez dwa lata RCITMOiN prowadził badania komputerowe we wszystkich specjalnościach stażowych: terapii, chirurgii, położniczo-ginekologii, pediatrii, chirurgii dziecięcej, ogólnej praktyce lekarskiej, stomatologii. Głównym celem takiego niezależnego egzaminu jest podniesienie jakości kształcenia medycznego.

Analiza porównawcza Wyniki testów na przestrzeni dwóch lat wykazały poprawę wiedzy teoretycznej absolwentów. Wynikało to z jakości bazy zadań testowych oraz zwiększonej odpowiedzialności zarówno stażystów, jak i nauczycieli. Jeśli porównamy średnie wyniki wśród uczelni, można zauważyć stabilność wskaźników Państwowego Uniwersytetu Medycznego w Karagandzie (średnia ocen w 2010 r. wyniosła 74,0, co było najlepszym wynikiem wśród uczelni medycznych, a w 2011 r. – 80,3).

W 2011 r. we wszystkich uczelniach gwałtownie spadła liczba ocen niedostatecznych (z 40% w 2010 r. do 7,5% w 2011 r.). W 2011 roku w stanie Uniwersytet medyczny w Semey zanotowano minimalny odsetek niezadowolenia

Ryż. 1. Wyniki testów (średnia ocen dla uczelni)

Ryż. 2. Wyniki sprawdzianów (% ocen niedostatecznych)

Ryż. 3. Wyniki testów (średni wynik według specjalizacji)

Ryż. 4. Wyniki sprawdzianów (% ocen niedostatecznych według specjalności)

oceny dostateczne (0,5%).

Analiza wyników egzaminów według specjalności wykazała, że najgorsze wskaźniki wiedzy teoretycznej osiągnęli stażyści, którzy kształcili się na specjalnościach „ogólna praktyka lekarska” i „stomatologia”.

Na podstawie wyników ujednoliconego testu komputerowego,

W roku akademickim 2009-2010 odsetek ocen niedostatecznych ze wszystkich specjalności stażu wyniósł 34,8%, średnia ocen 63,0. W roku akademickim 2010-2011 odsetek ocen niedostatecznych ze wszystkich specjalności spadł do 7,1%, a średnia ocen wzrosła do 80,0.

Medycyna i ekologia, 2012, 2

W 2011 roku komisja odwoławcza miała charakter scentralizowany i pracowała w oparciu o RCITMO-iN, co wpłynęło na jakość jej pracy. Jeżeli w 2010 roku utworzono komisję odwoławczą na bazie każdej uczelni i składała się ona z kadry dydaktycznej tej samej placówki edukacyjnej i prawie wszystkie złożone wnioski zostały rozpatrzone pozytywnie, to w 2011 roku przedstawiciele wszystkich uczelni medycznych stali się członkami jednej scentralizowanej komisji odwoławczej . Przy takiej organizacji pracy komisji odwoławczej odsetek pozytywnie rozpatrzonych odwołań wyniósł zaledwie 16,9%.

Podczas testów komputerowych zidentyfikowano pewne problemy. W związku z tym istniała niewystarczająca liczba przeszkolonych testologów i ekspertów, istniało ryzyko „stronniczości” w kierunku szkolenia stażystów w zakresie rozwiązywania problemów testowych kosztem szkolenia klinicznego, stosowania środków komunikacji przez stażystów podczas testów oraz braku uzasadnione ramy regulacyjne.

Zdaniem autorów sposobów rozwiązania zidentyfikowanych problemów należy szukać w organizowaniu seminariów szkoleniowych dla testologów i ekspertów, zatwierdzaniu listy przeszkolonych ekspertów, przeprowadzaniu niezależnej certyfikacji umiejętności praktycznych (egzamin nie powinien ograniczać się wyłącznie do testowania), zakupach i używanie podczas testów środków zakłócających komunikację komórkową.

Analiza wyników badań komputerowych na przestrzeni 2 lat wykazała, że przeprowadzanie egzaminów stażystów może stać się skutecznym narzędziem samodzielnej oceny wiedzy absolwenta uczelni. Na tej podstawie ocena wiedzy może stanowić podstawę do dalszego rozwoju systemu zewnętrznej oceny osiągnięć edukacyjnych absolwentów w kształceniu medycznym. Bardzo ważne jednocześnie wzrasta odpowiedzialność kadry nauczycielskiej za jakość kształcenia specjalistów.

Otrzymano 07.05.2012

A. S. Kusainova, B. S. Imasheva, K. K. Dosmambetova, L. Zh. Karsakbayeva, G. A. Derbisalina, A. U. Baydusenova, A. A. Kauysheva, A. K. Yeshmanova ANALIZA WYNIKÓW BADAŃ PRÓBNYCH STAŻANTÓW MEDYCZNYCH

Analiza wyników testów komputerowych trwających 2 lata wykazała, że przeprowadzenie egzaminu stażystów może stać się skutecznym narzędziem samodzielnej oceny wiedzy absolwenta szkoły. Tym samym poświadczenie wiedzy może stanowić podstawę do dalszego rozwoju zewnętrznej oceny osiągnięć edukacyjnych absolwentów kierunków medycznych. Duże znaczenie ma zwiększona odpowiedzialność kadry kierowniczej za jakość kształcenia.

A. S. Kusayynova, B. S. Imasheva, K. K. Dosmambetova, L. Zh. Karsatsbaeva, G. A. Derbkalina, A. U. Bayduysenova, A. A. Kauysheva, A. K. Eshmanova D6R1GER-INTERNDERD1 SONA TEST1LEUDSH N6TIZHELER1N TALDAU

EKi zhylry komputerlk testsheu netizhelersh taldauy internderge emtihandar etyuzudsch zhorary oku orny tYlekterinich 6miMiH teuelaz baralau kuraly bola alatynyn kersetken. Soran baylanysty, etyuztgen 6miMcertyfikattauynmedicallyk 6miM berudep oku zhepspktermsch syrtky baralau zYYesin odan eri damytura negiz retinde kabyldaura bolada. Bul rette profesor-okytushylar kuramynych mamandardy sapali dayarlaudar zhauapkershiligin arttyrudych machyzy zor.

Analiza wyników testowanie próbne na 28.10.09 Placówka Państwowa „Szkoła Gimnazjum nr 6” klasa 11.

1. W egzaminie wzięło udział 30 studentów z 30, co stanowi 100% absolwentów.

2. Średni wynik wynosi 77,8, czyli jest o 0,1 punktu wyższy od wyniku ostatniego testu, jakość wiedzy wynosi -20%, czyli jest o 10% niższa od wyniku ostatniego testu. sukces akademicki 100%.

A) Dodatnia dynamika średnich wyników i jakości wiedzy z przedmiotów:

Język rosyjskiśredni wynik to 19, czyli o 1 punkt wyższy niż wynik poprzedniego testu, jakość -90%, wyniki w nauce -100%, nauczyciel - Dmitrieva T.M.;

Upadające tematy:

Sekcja Morfologii i Ortografii;

Składnia i interpunkcja:

Style mowy;

Powoduje:

nie zakończył się etap wstępnego powtarzania kursu języka rosyjskiego w szkole podstawowej

- Geografiaśredni wynik wynosi 11,9%, czyli jest o 1,9% wyższy od wyniku ostatniego testu, jakość -42,9, czyli jest o 42,9% wyższy od ostatniego wyniku testu, wyniki w nauce -100%, nauczyciel - Zhezher L.S.;

Upadające tematy:

Obszary przyrodnicze świata i Republiki Kazachstanu;

„Struktura skorupy ziemskiej”

Powoduje:

Wielu uczniów nie zdecydowało się jeszcze do końca na wybór piątego przedmiotu;

Etap wstępnego powtarzania materiału nie został zakończony.

B) Ujemna dynamika przeciętnego wyniku i jakości wiedzy z przedmiotów:

. Język kazachski średni wynik - 18, czyli niższy od poprzedniego o 0,2, jakość 90%, czyli wyższy od poprzedniego o 3,3%, wyniki w nauce - 100%, nauczyciel - Mamelbaeva G.S., Kuishinova Zh.T.

Upadające tematy:

- rozumienie terminów językowych;

- jednostki frazeologiczne;

- składnia;

- Powoduje:

Ograniczony leksykon

. Matematykaśrednia ocen to 11,5, czyli o 0,5 mniej od wyniku poprzedniego testu, jakość -50, czyli o 3,3% niższa od wyniku ostatniego testu, wyniki w nauce -100% nauczyciel - Matais T.V.;

Upadające tematy:

Zadania tekstowe dotyczące układania równań i układów równań;

Postęp;

Równania i nierówności irracjonalne;

logarytmy, wyrażenia logarytmiczne, równania i nierówności;

- Powoduje:

Nieudany materiał;

Wstępny etap powtórki nie został ukończony;

Brak motywacji do nauki wzorów matematycznych.

. Historia K.średni wynik - 14, jakość - 53,3%, czyli o 10% niższa od wyniku ostatniego testu, wyniki w nauce - 100%, nauczyciel - Guseva E.E.; Upadające tematy:

Okres sowiecki w historii Kazachstanu:

Reformy administracyjno-terytorialne XIX w.;

Plemiona i związki plemienne na terytorium starożytnego Kazachstanu.

Powoduje:

Niewystarczający poziom samokształcenia studentów;

Niski poziom motywacji uczniów;

Nieracjonalnie szeroki zakres zmian w treści pytań w zbiorach testowych

różne lata;

Duża liczba zbyt szczegółowych pytań, na które odpowiedzi są różne

różne źródła, podczas gdy na pierwszy plan wysuwają się drobne szczegóły.

. Fizykaśrednia ocen to 10,1, czyli o 0,6 mniej od wyniku poprzedniego testu, jakość -20, czyli o 5% niższa od wyniku ostatniego testu, wyniki w nauce -100%, nauczyciel - T.I. Galoton;

Upadające tematy:

Pierwsza zasada termodynamiki;

Nawigacja według map;

- Prawo Coulomba;

Praca z wykresami;

Podstawowe równanie MKT.

Powoduje:

Brak systemu samokształcenia;

Zwiększony poziom niepokoju;

. Biologiaśrednia ocen – 17, jakość – 87,5, czyli o 3,4% niższa od wyniku ostatniego egzaminu, wyniki w nauce – 100%, nauczyciel – Bojko G.S.;

Upadające tematy:

- „Rozwój życia na Ziemi”;

- „Korzeń, łodyga, liść”;

- „Porosty”:

- „Wyższa aktywność nerwowa”;

Powoduje:

Materiały szkoleniowe nie zostały ukończone;

Błędy w testach;

5. Procent w wyborze piątego przedmiotu:

Fizyka – 33,3%, biologia – 26,6%, geografia – 23,5%, język obcy- 16,6% - plany zawodowe absolwentów.

6. Podział uczniów według liczby zdobytych punktów:

0-49 - 1; 50-59-3; 60-70-8; 71-89-11; 90-100-2; 101 i więcej -4.

8. Liczba studentów, którzy na koniec ostatniego roku osiągnęli wynik „4” i „5”, wynosi 15, a

na podstawie wyników badań próbnych - 6. Mają ocenę „3” Belozor I- w historii; Bushuev D - z matematyki, historii K, fizyki; Kolesnichenko K. – z matematyki.; Pleshakova E - z fizyki, historii K; Solovyova E - z fizyki; Shumyakova N - z fizyki, historii K; Yatsenko V - z fizyki; Kulinich K – z matematyki; Vakalov A - z fizyki, historii K.

Sposoby rozwiązywania problemów:

1. Ze względu na rosnącą złożoność zadań testowych należy w dalszym ciągu analizować system powtarzania materiałów i prac uczniów objętych nowym zbiorem Testy 2009. Ustrukturyzować błędy popełniane przez uczniów i organizować powtórki tematyczne. Dostosuj plany przygotowań do UNT.

2. Przedstaw racjonalne techniki zapamiętywania formuł. Nauczyciele matematyki i fizyki przeprowadzą cykl konsultacji tematycznych dotyczących rozwoju technik i umiejętności samokontroli wykonanej pracy. Kontynuuj warsztat rozwiązywania problemów wymagających powtarzania kolejnych operacji, zwróć uwagę uczniów na zmiany w treści zadań, nakieruj ich na wyznaczenie racjonalnego algorytmu, wykonaj zadanie testowe i powtórz racjonalne metody operacji obliczeniowych.

3. Podnieść jakość konsultacji dla studentów

Opracuj racjonalny algorytm wykorzystania materiałów referencyjnych do kursu.

- Nauczyciele przedmiotów powinni przeanalizować historię Kazachstanu i geografię

możliwości biblioteki w zakresie materiałów periodycznych. Zaoferuj uczniom dane

źródeł informacji, badania i sporządzania notatek w zakresie nowych statystyk

dane według sekcji programu. - Utrzymuj systematyczność i celowa praca z kategorią studentów,

mając jedną „trójkę” zgodnie z wynikami testów.

5. Administracja szkoły powinna wzmocnić kontrolę nad organizacją i jakością wydarzenia.

nauczyciele przedmiotów praca korekcyjna ze studentami, dla efektywności

systematyczne powtarzanie materiału edukacyjnego.

5. Kontynuować systematyczne przygotowanie do testów w nowym formacie, uwzględniać negatywne aspekty testów próbnych oraz dostosowywać plany przygotowań uwzględniając cechy testów w nowym formacie.

Przygotowane przez Miroshnik N.V.

Podczas wykonywania zadań w teście „Kostki Kosa” tok myślenia osoby badanej jest niejako rzutowany na zewnątrz. Eksperymentator ma zatem dość rzadką możliwość nie tylko ilościowej oceny mierzonych zdolności intelektualnych, ale także poznania cech jakościowych stymulowanych przez test procesów analitycznych i syntetycznych. Korzystając z okazji, scharakteryzujmy najpierw proces myślowy, który zachodzi podczas układania „Kostek Kos”. Jest to konieczne dla głębszego zrozumienia i interpretacji uzyskanych wyników.

„Wzór przedstawiony na karcie jest postrzegany przez podmiot jako integralna całość i należy go mentalnie podzielić na kilka części o równej wielkości. W tym przypadku podmiot musi zdać sobie sprawę, że liczba tych części jest równa liczbie dostępnych kostek. To jest problem analityczny temat"

Podział wzoru na osobne części odpowiadające jednej kostce może nastąpić na różne sposoby. Jeżeli jednak badany nie przeprowadził takiej analizy, to składanie wzoru będzie przebiegało całkowicie metodą prób i błędów, lub poprzez znalezienie podobieństw pomiędzy poszczególnymi częściami wzoru i poszczególnymi kostkami.

Załóżmy, że została przeprowadzona prawidłowa analiza wzoru (u niektórych osób objawia się to bardzo charakterystycznie w zachowaniu. Długo w milczeniu przyglądają się wzorowi, po czym mówią: „No więc”). Potem następuje etap syntezy, który psychologicznie przebiega różnie u różnych osób. Niektórzy badani planują w myślach niemal cały proces składania, a następnie pracują systematycznie, układając kostki jedna po drugiej, albo w rzędach od lewej do prawej, albo w kolumnach od góry do dołu, albo od środka do obrzeży, albo układając identyczne lub symetryczne części wzoru jedna po drugiej. Co więcej, w zdecydowanej większości przypadków badani z tej grupy nigdy nie „przymierzają” kostek, lecz obracają je w dłoni o żądaną krawędź i natychmiast odkładają na miejsce. Na podstawie tego zewnętrznego zachowania można założyć, że analiza i synteza wzoru została tutaj zakończona na początku fałdowania; synteza wyprzedza fałdowanie.

W innej grupie badanych można zaobserwować inny obraz zewnętrzny. Badani również szybko i dokładnie składali kostki, ale nie cały wzór, ale jakąś jego część, mniej więcej kompletną. Potem myślą przez jakiś czas i zaczynają składać kolejną część wzoru. W tej grupie kostki również nie są przymierzane, ale natychmiast umieszczane z żądaną krawędzią. Mamy zatem do czynienia z procesem myślowym o tej samej strukturze wewnętrznej, co w grupie pierwszej. Jedyna różnica polega na tym, że w tym przypadku badani analizują wzór fragmentarycznie, a nie w całości.

W trzeciej grupie osób składanie odbywa się w zasadniczo odmienny sposób. Badani biorą sześcian w dłonie i obracając go, próbują znaleźć podobieństwo jednej lub drugiej jego ścian z dowolną częścią wzoru. Po ułożeniu w ten sposób pierwszej kostki badani w ten sam sposób przymierzają drugą i tak dalej. W tym przypadku dość często zachodzi następujące zjawisko: po obróceniu w dłoniach jednej kostki i oczywiście nie zgadnięciu, na którą stronę ją położyć, podmiot odkłada tę kostkę na bok i bierze inną, chociaż wie, że wszystkie kostki są To samo. Przy tej metodzie składania badani najwyraźniej nie dokonują wstępnego analitycznego podziału wzoru, nie ma także procesów syntetycznych, które zastępuje proces porównania dyskryminacyjnego. Co więcej, punktem wyjścia do takiego porównania często nie jest jakiś fragment wzoru, ale sama kostka.

W gorszych przypadkach badani obracają kostkę w rękach, układają ją zupełnie nieprawidłowo, a na pytanie eksperymentatora, czy należy ją tak ułożyć, odpowiadają twierdząco.

Wiadomo, że w trakcie testowania sposoby dodawania kostek mogą się zmieniać, jednak dla doświadczonego eksperymentatora wyraźnie widać dominację myślenia „planistycznego”, opartego na rozwiniętych operacjach analizy i syntezy.”

Wskaźniki ilościowe charakteryzują poziom rozwoju inteligencji niewerbalnej (praktycznej, wizualnej) i zdolności analityczno-syntetycznych leżących u podstaw talentu intelektualnego. Uzyskane wyniki interpretuje się w zależności od zakresu i znaczenia wskaźnika.

Szereg zastosowań

| Wartość wskaźnika | Niski | Wysoki |

| Medycyna: identyfikowanie objawów niektórych zaburzeń neuropsychologicznych. | Możliwe organiczne zaburzenia ośrodkowego układu nerwowego system nerwowy, zaburzenia koordynacji wzrokowo-ruchowej, apraksja | |

| Edukacja: ocenę potencjalnych możliwości uczenia się i rozwój intelektualny. | Trudności w uczeniu się i rozwijaniu innych funkcji intelektualnych | Dobre możliwości rozwoju intelektualnego, niezależnie od posiadanego wykształcenia, wysoki poziom ogólnej zdolności uczenia się |

| Poradnictwo i wybór kariery: ocena możliwości zawodowych i przydatności psychologicznej specjalistów w określonych zawodach technicznych i artystycznych. | Trudności w wykonywaniu konstruktywnych czynności, przeciwwskazania psychologiczne dla inżynierów, projektantów, mechaników, operatorów maszyn, konstruktorów, projektantów, projektantów mody, krojców, krawców itp. | Możliwość pomyślnej realizacji działań konstruktywnych, dobre warunki wstępne dotyczące zdolności technicznych. |

Cechy zachowania osób badanych, które podczas badania powtarzają się wielokrotnie, czyli pojawiają się na poziomie trendu, są dodatkowymi wskaźnikami jakościowymi testu. Wskaźniki jakościowe nie tylko dodatkowo charakteryzują poziom rozwoju zdolności analityczno-syntetycznych i inteligencji niewerbalnej (wizualnie efektywnej), ale także odzwierciedlają indywidualne cechy aktywności poznawczej, cechy osobowości i sposoby reagowania emocjonalnego oraz indywidualne objawy psychopatologiczne.

| Zauważalne oznaki zachowania podmiotu | Interpretacja |

| Cechy aktywności poznawczej | |

| Nie mogę sobie poradzić z rozwiązaniem nawet tego pierwszego proste zadania | Naruszenia myślenia praktycznego, wizualnego i efektywnego |

| Niemożność rozwiązania problemu nawet po pokazaniu mu prawidłowego sposobu rozwiązania lub podczas powtarzania zadań | Upośledzenie pamięci wzrokowej i motorycznej, wyjątkowo niska zdolność uczenia się |

| Zbyt często odnosi się do próbki, patrzy na kostki | Upośledzenie pamięci wzrokowej, obniżony poziom rozwoju myślenia wizualno-figuratywnego |

| Rozwiązywać problemy przy użyciu znacznego wysiłku mięśni; napięcie, drżenie, niezręczne ruchy | Zaburzenia motoryki, zaburzenia organiczne ośrodkowego układu nerwowego |

| Mówi głośno o swoich działaniach, komentuje decyzję | Zaangażowanie funkcji werbalnych, trudności w wykonywaniu czynności praktycznych |

| Ma trudności ze zrozumieniem instrukcji i nie korzysta z podpowiedzi | Naruszenia inteligencja werbalna, niedostateczna nauka języka |

| Nie zauważa i nie poprawia błędów | Zaburzenia percepcji, uwagi, kontroli woli |

| Pracuje bardzo nierówno: niektóre zadania wykonuje szybko i poprawnie, inne wolno lub z błędami | Zmniejszona wydajność, zmęczenie |

| Cechy osobowości i stanu emocjonalnego | |

| Składa wzory beztrosko, łatwo rezygnuje z decyzji | Brak zainteresowania |

| Łatwo reaguje na drobne bodźce, ulega rozproszeniu | Labilność emocjonalna, niestałość, niestabilność działania, zaburzenia uwagi |

| Wytrwale dąży do znalezienia odpowiedniego rozwiązania, skupiając się na zadaniu | Planowość, celowość, stabilność działania |

| Szybko zaczyna składać obraz, spieszy się, działa metodą prób i błędów, które natychmiast poprawia | Impulsywność |

| Myśli przed przystąpieniem do składania wzoru, wstępnie rysuje plan rozwiązania, wstępnie układa kostki w określonej kolejności | Skłonność do refleksji, roztropność, organizacja, pedanteria |

| Łatwo zmienia sposoby rozwiązania problemu, próbuje różne warianty | Plastyczność, elastyczność |

| Uparcie próbuje rozwiązać problem w ten sam sposób, ma trudności z rezygnacją z nieskutecznego rozwiązania | Sztywność intelektualna |

| Mówi głośno, jest w ciągłym ruchu, macha rękami | Stan nadmiernego podniecenia |

| Rozwiązuj problemy po cichu, bezczynnie | Letarg |

| Krytykuje zadania, niszczy schemat, gdy zawodzi | Reagowanie agresywne w obliczu wyzwań |

| Waha się przy wyborze decyzji, szuka wymówek | Lęk, strach, chęć uniknięcia porażki, brak pewności siebie |

| Raduje się, śmieje, nie traci ducha, gdy zdarzają się niepowodzenia | Podwyższony nastrój |

| Krytykuje siebie, nie wyraża radości z sukcesów | Tendencja do reagowania depresyjnego |

| Dużo rozmawia z eksperymentatorem, zadaje pytania, dzieli się doświadczeniami | Pragnienie kontaktów |

| Cichy, nie odpowiada na pytania | Dystans, unikanie komunikacji |

| Wskazuje, żąda | Dominacja |

| Prosi o pomoc, szuka wskazówek, radzi | Uzależnienie |

Literatura

1. Pomiar inteligencji Kohsa S.S. Badanie psychologiczno-statystyczne oparte na teście konstrukcji blokowej. — Nowy Jork: McMilan, 1927.

2. Agafonova I. N., Kolechenko A. K., Pogorelova G. A., Shekhovtseva L. F. Metody badania inteligencji: Wytyczne. --Część 1. - St. Petersburg: St. Petersburg GIUU, 1991.

3. Anastasi A. Testy psychologiczne: Per. z angielskiego / wyd. Gurevich K.M., Lubovsky V.I. - Książka. 1. - M.: Pedagogika, 1982.

4. Testy Arbuzova V. N. Kosa. //Radziecka psychotechnika. -T. VII. - 1934, nr 1. -Z. 48-60.

5. Wino A, Simon T. Metody pomiaru uzdolnień umysłowych: Sob. artykuły. -- Charków: Państwo. wyd. Ukraina, 1923.

6. Bleikher V. M., Burlachuk L. F. Psychologiczna diagnostyka inteligencji i osobowości. - Kijów: Szkoła Podyplomowa, 1978.

7. Burlachuk L. F. Psychodiagnostyka osobowości. - Kijów: Zdrowie, 1989.

8. BurlachukL. F., Morozow S. M. Słownik-podręcznik nt diagnostyka psychologiczna. - Kijów: Naukova Dumka, 1989.

9. Gaida V. K., Zacharow V.P. Testy psychologiczne: Instruktaż. - L.: Leningradzki Uniwersytet Państwowy, 1982.

10. GilyashevaI. N, Praktyczne zastosowanie adaptowanego testu inteligencji w klinice chorób neuropsychiatrycznych: Zalecenia metodologiczne. - L.: B.I., 1987.

11. Glass J., Stanley J. Metody statystyczne w pedagogice i psychologii: Tłum. z angielskiego / Pod ogólnym, wyd. Adler Yu P. - M.: Postęp, 1976.

12. Eliseev O. P. Konstruktywna typologia i psychodiagnostyka osobowości. - Psków: POIUU, 1994.

13. Wykorzystanie techniki „Kosa Cubes” w celach diagnostyki zawodowej: Zalecenia metodyczne dla specjalistów w zakresie poradnictwa zawodowego i zatrudnienia. / Opracowano przez: Smirnova A.V., Khakhunova M.N. - Jarosław: Centrum Jarosławia

poradnictwo zawodowe i wsparcie psychologiczne dla ludności, 1995.

14. Kashin A.P. Skalowanie diagnostyczne funkcji psychofizjologicznych. //Badania teoretyczne i stosowane nad psychofizjologią różnic indywidualnych. - Kazań: KSU, 1973. - s. 4-16.

15. Kulagin B, V. Podstawy profesjonalnej psychodiagnostyki. -L.: Medicine, 1984. 16. Panasyuk A. Yu. Adaptowana wersja techniki D. Wekslera™ra. - M .: Instytut Badawczy Psychiatrii Ministerstwa Zdrowia RFSRR, 1973.

17. Panasyuk A, /O. Strukturalna analiza dynamiki rozwoju intelektualnego dzieci upośledzonych umysłowo i zdrowych: Streszczenie pracy dyplomowej. diss. pompa uch. Sztuka. Doktorat psychol. Nauka. - L., 1976.

18. Metody psychodiagnostyczne (w złożonym badaniu podłużnym studentów). - L.: Leningradzki Uniwersytet Państwowy, 1976.

19. Słownik psychologiczny / wyd. Davydova V.V., Zaporozhets A.V., Lomova B.F. itd. - M.: Pedagogika, 1983.

20. Serebryakova R. O. Zastosowanie ustandaryzowanego zestawu metod badania aktywności intelektualnej do rozwiązywania problemów diagnostycznych w niektórych chorobach neuropsychiatrycznych: Streszczenie pracy dyplomowej. diss, nasoisk. uch. Sztuka. Doktorat psychol. Nauka.

ZAŁĄCZNIK 2.

Przykład interpretacji wyników

FORMULARZ ZAPISU WYNIKÓW

PEŁNE IMIĘ I NAZWISKO. I. Siergiej Nikołajewicz data 23.04.2000

Wiek (lata) 49

Edukacja wyższy Zawód inżynier mechanik Dodatkowe informacje Poważny uraz mózgu

Suma punktów 24 Wynik standardowy (stan) 5

Stan techniki inteligencja niewerbalna: Przeciętny

Wykonywanie podczas testów: Często nawiązuje do wzorca, mówi głośno o swoich działaniach, nie zauważa swoich błędów, łatwo się rozprasza

WNIOSEK

Pomimo średni poziom produktywność wizualno-efektywnego myślenia, podmiot ma trudności z rozwiązaniem problemy praktyczne z powodu zaburzeń uwagi i braku dobrowolnej kontroli. Przy wystarczającym zachowaniu funkcji analizy i syntezy przestrzennej, percepcji wzrokowej i koordynacji ruchowej może nie być w stanie poradzić sobie ze złożonymi czynnościami konstrukcyjnymi, wymagającymi długotrwałej koncentracji uwagi, weryfikacji i porównania wyników. Problemy mogą pojawić się podczas wykonywania czynności technicznych, a także w procesie uczenia się i rozwiązywania złożonych problemów intelektualnych.

Ważnym warunkiem przeprowadzenia badań próbnych jest uzyskanie statystycznie wiarygodnych wyników, co zapewnia spełnienie szeregu warunków:

Badania pilotażowe należy przeprowadzić w kilku równoległych* grupach. Jednocześnie zaleca się przeprowadzenie go dwukrotnie w każdej grupie, pod warunkiem jednak, że badani otrzymają wersje testowe z zadaniami, na które wcześniej nie rozwiązywali. Wskazane jest, aby powtarzane badania pilotażowe w tej samej grupie przeprowadzać w różnych dniach;

Liczba osób w grupach powinna być odpowiednio duża (co najmniej 20 osób);

Wszystkie równoległe grupy muszą znajdować się na tych samych warunkach (czas przeznaczony na testowanie, miejsce i czas*);

Wszystkie przedmioty w ramach jednej grupy muszą także znajdować się w identycznych warunkach, bez żadnych „zniżek” i „odpustów” dla poszczególnych przedmiotów. Wszyscy przedmioty powinni otrzymać w przybliżeniu równe (równoległe) zadania pod względem złożoności;

Czas przeznaczony na testy próbne powinien być taki, aby najlepiej przygotowani mieli czas na udzielenie odpowiedzi na wszystkie pytania testowe*;

Aby uzyskać wiarygodne wyniki, należy zminimalizować możliwość podpowiedzi wśród badanych.

Badanie próbne z wykorzystaniem specjalistycznego programu i komputera PC podlega w przybliżeniu takim samym wymogom jak badanie „na papierze”.

Analiza wyników badań próbnych i dobór testów testowych

Zadania

Macierz wyników testów

Po badaniu próbnym sprawdzane są odpowiedzi osób zdających i przetwarzane są wyniki testu. Przetwarzanie wyników należy rozpocząć od zestawienia macierzy wyników badań (w przypadku komputerowej wersji badań macierze takie powinny być tworzone automatycznie przez program). Bardzo ważne jest, aby po numerze wersji testowej i numerze zawartego w niej zadania można było jednoznacznie określić, jakie zadania wykonał zdający. Jest to konieczne, aby, jak wspomniano powyżej, wykluczyć z ogólnego zestawu dokładnie te zadania, których nie można nazwać testowymi.

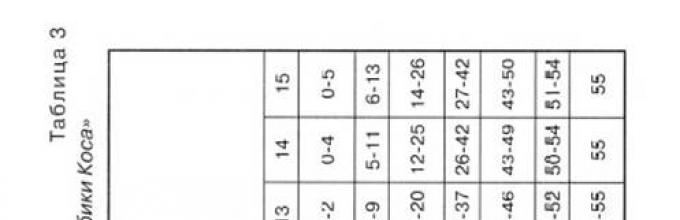

Zaleca się przygotowanie macierzy wyników badań przy pomocy komputera PC, np. edytora arkuszy kalkulacyjnych Excel, co znacznie ułatwi przetwarzanie danych i sprawdzenie właściwości statystycznych każdego zadania. Przykład takiej macierzy podano w tabeli. 3.4.

Tabela 3.4 – Matryca* wyników badań w grupie 10 osób

(do wszystkich zadań główna zasada oceny: odpowiedź prawidłowa – 1, błędna – 0)

| Przedmiot nr. | Nazwisko | Opcja testowa nr. | Numer zadania (zadania są ponumerowane i ułożone według rosnącej trudności: nr 1 /najłatwiejsze/ ® nr 10 /najtrudniejsze/) | Całkowity wynik testu | |||||||||

| Abramow | |||||||||||||

| Dmitriew | |||||||||||||

| Wasiliew | |||||||||||||

| Borysów | |||||||||||||

| Szczetinin | |||||||||||||

| Zykow | |||||||||||||

| Grigoriew | |||||||||||||

| Kiriłłow | |||||||||||||

| Iwanow | |||||||||||||

| Żukow | |||||||||||||

| S | - |

W macierzy wyników testów (tabela 3.4) linie z wynikami zdających należy ułożyć w porządku malejącym według sumy punktów zdobytych podczas testów, tj. w pierwszej linii - najsilniejszy uczeń, w ostatniej - najsłabszy. W kolumnach tabeli zawierających punkty osób badanych za każde z zadań testowych należy ułożyć zadania według rosnącego stopnia trudności, tj. od najłatwiejszego do najtrudniejszego.

Dolna część tabeli. 3.4 zawiera sumę punktów zdobytych przez wszystkich zdających za każde z 10 zadań testowych. To właśnie ta suma (dokładniej jej wartość odwrotna) służy w ogólnym przypadku miarę trudności zadania i kryterium, według którego to lub inne zadanie otrzymuje swoje miejsce ( numer seryjny) w systemie zadań testowych. Początkowo, jak wspomniano powyżej, nauczyciel określa stopień trudności zadań na podstawie własnego doświadczenia. Dolna linia matrycy wyników testu zawiera bardziej obiektywną ocenę trudności zadań, która w niektórych przypadkach może nie pokrywać się z początkową opinią nauczyciela. W takiej sytuacji zadanie, którego trudność różni się od pierwotnie zakładanego, należy umieścić w innym miejscu, przypisując mu nowy numer odpowiadający jego trudności. Należy w tym przypadku uwzględnić odpowiedzi na to samo zadanie uzyskane w innych (równoległych) grupach przedmiotów.

Analiza statystyczna wyniki testów i wybór zadań

Do włączenia do testów

W tabeli Tabela 3.5 przedstawia niektóre wskaźniki obliczone na podstawie wyników badań próbnych.

Tabela 3.5 – Analiza wyników testów*

| WSKAŹNIKI | Numer pracy | |||||||||

| Liczba poprawnych odpowiedzi | ||||||||||

| Liczba błędnych odpowiedzi | ||||||||||

| Proporcja poprawnych odpowiedzi, P J | 0,8 | 0,7 | 0,6 | 0,5 | 0,5 | 0,4 | 0,3 | 0,2 | ||

| Proporcja błędnych odpowiedzi, Q J | 0,2 | 0,3 | 0,4 | 0,5 | 0,5 | 0,6 | 0,7 | 0,8 | ||

| Potencjalne trudności Q J/ P J | 0,00 | 0,25 | 0,43 | 0,67 | 1,00 | 1,00 | 1,50 | 2,33 | 4,00 | - |

| Rozproszenie punktów, P j× Q J | 0,16 | 0,21 | 0,24 | 0,25 | 0,25 | 0,24 | 0,21 | 0,16 | ||

| Współczynnik korelacji ocen zadania z łączną punktacją za cały test | - | 0,41 | 0,62 | 0,75 | 0,82 | 0,82 | 0,75 | 0,62 | 0,41 | - |

Najważniejsze z wymienionych w tabeli. Wskaźniki 3.5 to:

1) potencjalne trudności;

2) rozproszenie punktacji;

3) współczynnik korelacji ocen zadania z łączną punktacją z całego testu.

Wskaźniki te są kryteriami, według których można ocenić, czy zadanie w formie testowej można wykorzystać w testach, tj. Zostać wezwanym zadanie testowe .

Pierwszy wskaźnik spełnia warunek (patrz sekcja 1.2) znana trudność zadania. Jak widać z tabeli. 3.5 zadania nr 1 i 10 nie spełniają tego wymogu, co implikuje konieczność ich „poprawienia” przez wykonawcę w celu ustalenia przyczyn (zadanie jest zbyt łatwe lub zbyt trudne, błędnie sformułowane, zawiera „ wskazówka” w opcjach odpowiedzi, jest błędnie postrzegana przez zdających itp.). P.). Po „poprawce” zadanie jest albo przerabiane, albo eliminowane i nie jest wykorzystywane w testach.

Równie ważne jest rozproszenie ocen, które może służyć jako wskaźnik zdolność różnicowania zadania, tj. jego umiejętność dzielenia grupy podmiotów na mocnych i słabych. Im większe rozproszenie punktacji, tym lepsza zdolność różnicująca zadania. Jednakże zadania o niskim rozproszeniu (np. zadania nr 2 i 9) można wykorzystać także w testach (biorąc pod uwagę wartość współczynnika korelacji z łączną punktacją z całego testu). Takie zadania pozwalają wyraźniej oddzielić tych, którzy są całkowicie nieprzygotowani, od tych, którzy wiedzą na „3”, a zatem tych, którzy wiedzą na „5”, od tych, którzy „nie osiągają” maksymalnego wyniku.

Trzecim wskaźnikiem jest współczynnik korelacji wyników zadania z łączną punktacją za cały test , jest najważniejszy. Jeśli jego wartość jest niewielka, najwyraźniej można obejść się bez odpowiedniego zadania w teście. Przeciwnie, zadania o dużej wartości określonego współczynnika (powyżej 0,7) można uznać za zadania „wiodące”, „testujące”, „kluczowe” dla danej dyscypliny lub jej sekcji. Zaleca się uwzględnienie zadania w teście pod warunkiem, że współczynnik korelacji będzie nie niższy niż 0,25-0,3.

Do obliczenia współczynnika korelacji w naszym przypadku najwygodniejszym wydaje się wzór

gdzie jest ocena za zadanie; - łączny wynik testu; - liczba przedmiotów w grupie.

Dla przykładu obliczmy współczynnik korelacji wyników z zadania nr 5 z sumą wyniki testu w odniesieniu do macierzy wyników badań podanej w tabeli 3.4 (patrz tabela 3.6).

Tabela 3.6 – Obliczanie współczynnika korelacji S

Używany do analizy wyników testów wyposażenie komputera Do obliczenia współczynników korelacji zaleca się wykorzystanie odpowiedniej funkcji edytora arkuszy kalkulacyjnych Excel.

Nie mniej ważne jest porównanie wyników badań uzyskanych w równoległych (różnych) grupach. Porównanie to przeprowadza się poprzez porównanie potencjałów trudności, wariancji i współczynników korelacji wyników zadań z całkowitymi wynikami testu, które w idealnym przypadku powinny się nieznacznie różnić. Istotne różnice w tych wskaźnikach mogą świadczyć albo o małej powtarzalności wyników testów (tj. w grupach o tym samym poziomie ten sam test daje różne wyniki), albo o znacząco różnym poziomie przygotowania zdających w różne grupy(tj. grupy nie są równoległe).

Równoległość grup można sprawdzić oceniając jednorodność wariancji całkowitych wyników testów, stosując odpowiednie kryteria statystyczne – Fisher, Cochran, Bartlett. Stosując te kryteria, przy odpowiednio wysokim poziomie istotności (zalecane 0,05), można sprawdzić, jak grupy równoległe różnią się średnim poziomem przygotowania.

Inną techniką, którą można zastosować podczas przetwarzania wyników testów, jest łączenie wyników testów z równoległych grup. Technikę tę zaleca się stosować w przypadku niewielkiej liczby pacjentów oddzielne grupy, jednak przed „połączeniem” wyników warto sprawdzić jednorodność wariancji według powyższych kryteriów.

Wyniki testu

Wyniki badań należy interpretować w sposób zgodny z celem badania (patrz tabela 4.1).

Tabela 4.1 – Obszary zastosowania badań, cel badania i interpretacja jego wyników

|

Szereg zastosowań testy |

Cel testowania |

Interpretacja Wyniki testu |

|

Profesjonalna selekcja |

Wyłonienie tych, którzy najlepiej spełniają wymagania, posiadają wiedzę i umiejętności niezbędne w zawodzie |

Ranking przedmiotów według poziomu przydatności zawodowej, kompetencji, kompleksowa analiza wyników |

|

Testy wstępne |

Wybór najlepiej przygotowanego (definicja zaliczenie), identyfikując luki w strukturze wiedzy |

Ranking przedmiotów według poziomu przygotowania, statystyczne opracowanie wyników |

|

Określenie „miejsca” w grupie dla każdego przedmiotu według wybranych kryteriów |

Ranking badanych według mierzonego parametru, obróbka statystyczna wyników |

|

|

Kontrola prądu* 14, monitoring |

Śledzenie postępów proces edukacyjny, identyfikacja luk w strukturze wiedzy badanych i identyfikacja możliwych przyczyn ich występowania |

Analiza struktury i profilu wiedzy, statystyczne opracowanie wyników |

|

Zdalny Edukacja |

Stymulacja poznawcza działalność studentów, zwiększenie motywacji do nauki, śledzenie postępu procesu edukacyjnego, identyfikowanie luk w strukturze wiedzy przedmiotów i odkrywanie możliwych przyczyn ich występowania |

Ranking przedmiotów według poziomu przygotowania, analiza przez nauczyciela (opiekuna) struktury i profilu wiedzy, statystyczne opracowanie wyników |

|

Samokształcenie (podręczniki multimedialne, programy szkoleniowe itp.) |

Stymulowanie aktywności poznawczej uczniów |

Wyniki testu są interpretowane przez osoby badane niezależnie lub za pomocą „podpowiedzi” programu. |

Jak wynika z tabeli. 4.1, badanie należy traktować jako całość: 1) metoda; 2) wyniki uzyskane określoną metodą; oraz 3) zinterpretowane wyniki uzyskane określoną metodą.

Interpretacja wyników testów odbywa się głównie w oparciu o średnią arytmetyczną, wskaźniki zmienności wyników testów oraz tzw. normy procentowe, pokazujące, jaki procent badanych ma wynik testu gorszy od badanego.

Podczas egzaminów wstępnych, selekcji zawodowej lub ustalania oceny w grupie głównym zadaniem interpretacji wyników jest uszeregowanie zdających według ich poziomu przygotowania. Podczas monitorowania lub kontrola prądu ważniejszym zadaniem jest analiza struktury i profilu wiedzy. Podczas samodzielnej pracy (kształcenie na odległość, nauka z wykorzystaniem podręczników multimedialnych itp.) głównym celem testów jest pobudzenie aktywności poznawczej uczniów, umożliwienie im oceny własnych sukcesów i zidentyfikowanie luk w zdobytej wiedzy.

Niezależnie od zakresu badania, wyniki badań muszą zostać poddane obróbce statystycznej w celu określenia głównych cech obiektów badań, sprawdzenia wiarygodności pomiarów i aktualności wyników badań.

Testy wstępne. Pierwotne przetwarzanie wyników uzyskanych podczas egzaminów wstępnych sprowadza się do zestawienia tabeli (macierzy) wyników testów według zasad opisanych wcześniej (patrz tabela 3.4). Pozwala to nie tylko jednoznacznie ocenić poziom i strukturę przygotowania osób badanych, ale także zidentyfikować „najsilniejszych” w badanej grupie.

Jak zauważono w Rozdziale 3, w przypadku dobrze zaprojektowanych testów rozkład wyników testów powinien być w idealnym przypadku zbliżony do normalnego (w odpowiednio dużych grupach – co najmniej 20 osób). Na ryc. Rysunek 4.1 przedstawia przykładowy rozkład punktów zdobytych podczas egzaminu wstępnego w grupie 80 osób. Zadanie polegało na wyłonieniu z tej grupy 50 najlepiej przygotowanych osób. Test składał się z 24 zadań, za każdą poprawną odpowiedź przyznawany był 1 punkt. Na podstawie łącznej liczby zdobytych punktów komisja selekcyjna wybrała pierwszych 50 osób, które zdobyły punkty największa liczba punktów i zostaje określony wynik pozytywny (w tym przykładzie - 11 punktów).

Ryż. 4.1 - Ustalanie pozytywnej oceny egzaminu wstępnego (przykład).

Maksymalna możliwa liczba punktów w tym przykładzie wynosi 24.

Przykład pokazany na ryc. 4.1 jest w pewnym sensie „idealny”. Gdyby więc w tym samym przykładzie trzeba było wybrać nie 50, a 52 osoby (czyli np. 47 osób), to pojawiłyby się pewne trudności z ustaleniem wyniku pozytywnego – przy niższej wartości (10 punktów) byłoby więcej osób który zdał egzamin niż było to konieczne i odwrotnie. W tej sytuacji można zaproponować następujące rozwiązanie: komisja rekrutacyjna ustala wyższą ocenę pozytywną, przy której liczba osób zdających egzamin jest mniejsza od wymaganej. Komisja wybiera brakującą liczbę osób spośród tych, którym nieznacznie zabrakło do wymaganego wyniku. W takim przypadku pierwszeństwo mają ci, którzy najlepiej spełniają wymagania (na przykład mają doświadczenie zawodowe w wybranej specjalności, świadczenia przy przyjęciu, wyższą średnią ocen z podstawowych dokumentów edukacyjnych itp.). Tym samym osobom za dodatkową opłatą można zaproponować odbycie kursów przygotowawczych itp.

Podczas egzaminów wstępnych, oprócz określenia pozytywnej oceny, dość istotna jest analiza struktury i profilu wiedzy (o czym później).

Kontrola prądu (monitoring). Testy do kontroli i monitorowania prądu tworzone są według tych samych zasad, co testy do innych celów. Jednak głównym celem testów w tym przypadku jest śledzenie postępu procesu edukacyjnego, identyfikacja luk w strukturze wiedzy, zniekształceń w profilu wiedzy każdego z zdających i wyjaśnienie możliwe przyczyny ich wygląd.

Pod struktura wiedzy Najogólniej przez pojęcie należy rozumieć taki stopień kompletności wiedzy i umiejętności studenta, który obejmuje równomiernie wszystkie działy dyscypliny (lub kilka dyscyplin) i pozwala na pomyślne zakończenie zadań testowych przez podmiot, niezależnie od tego, do którego działu dyscypliny należy.

Jeżeli przedmiot wykonuje zadania (w tym dość trudne) z jednego działu dyscypliny, a nie może wykonać zadań z innego działu (w tym o niskim stopniu trudności), oznacza to naruszenie (luki) w strukturze wiedzy. Jest oczywiste, że zaburzenia tego typu mogą mieć charakter zarówno indywidualny, jak i obserwowany u ludzi duża liczba tematy. W tym drugim przypadku należy przeanalizować przyczyny pojawienia się luk (nieudana prezentacja sekcji lub poszczególnej dyscypliny, brak lub brak wsparcia metodologicznego itp.) i podjąć działania mające na celu ich eliminację.

Warunkiem koniecznym uzyskania wiarygodnych informacji o strukturze wiedzy jest reprezentatywność pozycji testowych w stosunku do ilości wiedzy, która jest za ich pomocą testowana. Innymi słowy, zadania zawarte na teście muszą w wystarczającym stopniu i równomiernie obejmować wszystkie działy dyscypliny, przedmiotu itp. W takim przypadku pożądane jest, aby każda sekcja dyscypliny była reprezentowana przez kilka zadań o różnym stopniu złożoności.

Dla wygody analizy struktury wiedzy wskazane jest uporządkowanie wyników testów w macierzy, jak pokazano w przykładzie (tabela 4.2). W tym przykładzie każda sekcja dyscypliny jest reprezentowana w teście przez pięć zadań o różnym stopniu trudności. Wyniki badanego nr 2, który rozwiązał zadania testowe według opcji nr 7, wykazały niemal całkowity brak znajomości działu 2 dyscypliny, natomiast mniej więcej poradził sobie z zadaniami z działu 1. W takich przypadkach mówi się o lukach w strukturze wiedzy.

Termin profil wiedzy , którą testolodzy nazywają sumą punktów w każdym wierszu tabeli wyników badań, można zilustrować przykładem podanym w tabeli. 4.3 (fragment macierzy z tabeli 3.4).

Tabela 4.2 – Analiza struktury wiedzy na podstawie macierzy wyników testów

|

Brak opcji testowych |

Oceny dla zadania testowe według sekcji dyscypliny (w ramach każdej sekcji zadania ułożone są według rosnącego stopnia trudności) | ||||||||||||

|

Sekcja 1 |

Sekcja 2 | ||||||||||||

Tabela 4.3 – Zniekształcone (wiersz nr 6) i niezniekształcone (wiersze nr 5 i nr 7) profile wiedzy

|

Brak opcji testowych |

Oceny za zadania testowe (zadania ułożone są według rosnącej trudności: nr 1 /najłatwiejsze/ nr 10 /najtrudniejsze/) |

Całkowity wynik testu |

||||||||||

Jak widać na przykładzie osoby, których wyniki znalazły się w wierszach 5 i 6, uzyskały na teście taką samą liczbę punktów, przy czym badany nr 5 poradził sobie z pierwszymi 5, najłatwiejszymi zadaniami, nie radząc sobie z resztą. Wyniki badanego nr 6 są nieco nielogiczne – nie radząc sobie na początku testu ze stosunkowo łatwymi zadaniami, radził sobie z zadaniami trudniejszymi. Mówi się wówczas o zniekształconym (odwróconym) profilu wiedzy.

Przyczyny zniekształceń profilu wiedzy mogą być bardzo różne – źle zaprojektowany test, indywidualne cechy psychologiczne osoby badanej, niska jakość nauczania, brak wsparcia metodologicznego i literatury itp. Zdaniem prof. VS. Avanesov i inni specjaliści ds. testów, zadaniem dobrej edukacji jest generowanie prawidłowych (niezakłóconych) profili wiedzy.

Analiza struktury i profilu wiedzy podczas egzaminów wstępnych oraz bieżącej kontroli (monitoringu) pozwala nauczycielom uzyskać ogólny obraz poziomu przygotowania zdających, szybko zidentyfikować luki w wiedzy, błędy w metodach nauczania i podjąć odpowiednie działania. W placówkach oświatowych wdrażających systemy zarządzania jakością stałe monitorowanie procesu uczenia się z wykorzystaniem technologii testujących powinno być jednym z głównych narzędzi ciągłego dostosowywania (udoskonalania) procesu edukacyjnego.

Nauka na odległość. Istniejące systemy nauczania na odległość (LMS „Prometheus”, „Web-class KhPI”, Lotus Learning Space itp.) z reguły zapewniają bieżące i ostateczne monitorowanie materiałów dydaktycznych. Sterowanie może odbywać się za pomocą osobnego programu testującego lub bezpośrednio wbudowane moduły (programy) do testów kursy na odległość.* 15 W tym drugim przypadku kurs zdalny może być wykorzystany do samodzielnej pracy, bez udziału nauczyciela.

Systemy nauczania na odległość, czyli same kursy na odległość, muszą być wyposażone w programy, które „mogą” nie tylko zapisać wyniki testów z każdego przedmiotu, ale także umożliwić nauczycielowi (opiekunowi) lub twórcy kursu przeprowadzenie ich statystycznej obróbki w minimalnym czasie wydane w celu określenia wiarygodności pomiaru pedagogicznego i ważności wyników testów. Niestety nie wszystkie stosowane systemy nauczania na odległość dają taką możliwość.

Testy opracowane do stosowania w nauczaniu na odległość podlegają takim samym wymogom, jak testy w ramach kontroli bieżącej (monitoringu).

Niezależna praca. Jak zauważają eksperci, dobrze opracowane testy mają duży potencjał uczenia się, co może znacząco zwiększyć motywację do nauki, a co za tym idzie, zwiększyć jej efektywność. Ostatnio w procesie edukacyjnym coraz częściej wykorzystuje się takie pomoce dydaktyczne, jak szkolenia, podręczniki multimedialne, symulatory elektroniczne itp., które można nazwać edukacyjnymi publikacjami elektronicznymi (EEP). Ich główną zaletą jest możliwość samodzielnej nauki przy minimalnej ingerencji nauczyciela. Należy zaopatrzyć EI w testy kontroli bieżącej i ostatecznej, najlepiej takie, które pozwolą uczniowi nie tylko zobaczyć, czego dokładnie nie wie, ale także „wyjaśnić”, dlaczego ta czy inna odpowiedź jest błędna i „zalecić” powrót do odpowiedni dział do ponownego przestudiowania.

Testy sprawdzające EI, a także testy przeprowadzane w innych celach muszą być reprezentatywne dla całości sprawdzanej wiedzy i umiejętności. Nie mniej ważne jest wstępne sprawdzenie zadań objętych tymi testami w celu określenia ich trudności i innych cech. Mając informację o trudności każdego zadania, twórca EI może mieć pewność, że podczas testowania program „przekaże” je testowanemu zgodnie z zasadą „od najłatwiejszego do najtrudniejszego”. W takim przypadku pożądane jest, aby mieć wystarczająco dużą liczbę równoległych zadań, aby podczas powtórnego badania zdający otrzymał nowe zadania, których wcześniej nie wykonywał.

W podręcznikach multimedialnych i innych materiałach edukacyjnych z reguły nie ma konieczności zapisywania wyników badań, a ponadto dokonywania ich statystycznej obróbki. Głównym zadaniem testów stosowanych w EI jest pobudzenie aktywności poznawczej ucznia i dostosowanie jego indywidualnej „trajektorii uczenia się”.